EXPO2025プロジェクトに参加して

長嶋洋一 (ASL)

概要 :大阪・関西万博2025の中で、2025年6月3日-8日の期間に「伝統文化未来共創Project」(The Future in Tradition)という企画が、[EXPOホール"シャインハット"、ギャラリーEAST、ポップアップステージ南] の3会場で開催された。この中の「伝統の中にある未来 ー Japanese Experience ー」というギャラリーEASTでのイベントとして、作曲家/笙演奏家の東野珠実氏が企画したのが、「Breathing Media Projects 〜Body as Traditional Media〜」コンサート(6/3)と、「Breathing Media Projects 〜呼吸する伝統〜」レクチャー/デモンストレーション(6/6)の2件であり、筆者は東野氏に依頼されてこのプロジェクトに参加した。作曲家/バイオリン奏者の木村まり氏(ジュリアード音楽院教授)や研究者のGerard Assayag氏(IRCAM)と共に参加して、伝統文化(雅楽/舞楽)とテクノロジーの融合について紹介したこのイベントの様子や、計3件の作品(Max Programming担当)として協力した筆者の事例について紹介する。Participating in the EXPO2025 Project

Yoichi Nagashima

(このページは制作途上の暫定版です)

1. はじめに

「大阪・関西万博2025」(大阪・夢洲)は、本稿執筆時点(2025年7月中旬)において開幕から折り返して残り3ヶ月ほどあり、音楽情報科学研究会・夏のシンポジウムで報告する時点でも絶賛開催中である。筆者は2025年6月3〜8日の期間に、この万博の「伝統文化未来共創Project(伝統の中にある未来)」[1]という企画に関連するプロジェクトに協力して参加(出演)した。公式コンセプト紹介動画[2]には日本の伝統文化/伝統芸能などの巨匠が登場するばかりで「未来」があまり見えない中、賛同者として加わった笙演奏家/作曲家の東野珠実さん[3]★は、「伝統の中にある未来 ー Japanese Experience ー」というギャラリーEASTでのイベントとして、「Breathing Media Projects 〜Body as Traditional Media〜」(6/3)[concert]と、「Breathing Media Projects 〜呼吸する伝統〜」(6/6)[Lecture/Demonstration]という2件のComputer Musicプロジェクトを企画した。

東野珠実氏この企画は、東野さんが従来から続けてきた「Breathing Media」というテーマを中心に据えたものであり、作曲家/バイオリン奏者(ジュリアード音楽院教授)の木村まりさんやIRCAMの研究者・Gerard Assayagさんと共に、長年の友人である筆者にも協力依頼が届き、次節で述べるように多くの作品公演や海外ツアーなどでこれまで御一緒してきた[4]縁もあり、喜んで参加した。「主催」の日本経済新聞社や「後援」の商工会議所・関西財界や「協力」の多くの組織が名を連ねることもあって、半年前には既に看板[1]が立ち上がっていたプロジェクトも、実際に動き出したのは万博開幕直前の4月頃で、コンサートやレクチャーの中身が確定したのが開催日の前夜という強行軍だったが、可能な限りの情熱と努力が集結したイベントになった。本稿では、「笙」という伝統楽器を主役としつつ「未来」(新素材・コンピュータ・AI)を合体させ、「伝統文化」に偏った中でほぼ唯一「未来共創」イベントとなった本プロジェクトに関して、その背景と伏線(木村まりさんやIRCAMも登場。いろいろな「縁」が交錯し繋がっていた)、コラボレーションから本番までのプロセスについて報告し、新たな発展の可能性について検討したい。

2. 背景と伏線

2-1. 東野珠実さん

過去の資料を発掘すると国際会議ICMCに筆者はこれまで15回参加してきたが[5]、その6回目のICMC1997(ギリシャ・テッサロニキ)の会場で、東野珠実さんと出会った。ICMC1997レポート[6]によれば、東野さんは慶応SFCの岩竹徹さん作品の笙奏者として出演していたが、小坂直敏さんの紹介で知り合って同じ「Kyma使い」である事から「笙センサを作りましょう」と意気投合し、さっそく一緒に秋葉原に行って部品を探した。当時、東野さんは慶応SFC大学院生だったので、筆者はSFCのスタジオに行き「現代奏法の笙が生み出す、ありとあらゆるサウンド」★を録音した。ちなみに、この「多種多様な[笙]サウンド」★は後に、筆者が開催した特別講義「New relationships between culture, traditional music and electronic media」[7]の講師として2019年にニュージーランドから来日したRadek Rudnickiさん[8]によって、「日本の伝統楽器の音響素材を作曲のために共有する世界の音楽家コミュニティ」にも公開/提供された。筆者が新開発した笙ブレスセンサ[9]★★を用いて、自身の演奏する笙サウンドにKymaでライヴ音響処理を施す東野さんの作品"dinergy2"(→伏線[A])は翌年のICMC1998[ミシガン]に入選し、ここに研究発表参加していた筆者は公演のテクニカルサポートを行った[10]★。この作品は同じ月に「Kobe International Computer Music Festival」(1998)でも再演されたが、そのコンサートでは、「SFC録音「笙」音響素材」★を用いて笙ブレスセンサによりライヴ映像/音響を駆動する、という筆者の作品"Visional Legend"[11]も東野さんの演奏にて初演した。この会場・神戸ジーベックホールに聴衆として来ていたのが、京都での国際会議「IFAC/IFIP/IFORS/IEA Symposium on Analysis, Design, and Evaluation of Man-Machina Systems」のために来日していたドイツ・Kassel大学のGunnar Johannsen教授(研究者・音楽家)であり、日本の伝統音楽を愛するJohannsen教授は、東野さんの演奏した「笙」2作品をいたく気に入ってくれた(→伏線[B])。

筆者の笙ブレスセンサの開発研究はICMC1999(北京)にて「"It's SHO time" --- An Interactive Environment for SHO(Sheng) Performance」[12]として発表し、東野さんはモントリオールで活動する作曲家・梅崎さん作品の演奏者として参加して、筆者と東野さんは3年連続でICMCにて御一緒することになった[13]。その翌2000年のICMC2000(ベルリン)では、筆者の笙ブレスセンサや「筋電楽器」など多くのセンサ(新楽器)をテーマとした「Sensors for Interactive Music Performance」ワークショップ[14]の提案が採択され、多くの専門家が集まった[15]。ちなみに、国際会議のワークショップはアカデミックなので一般に「講師謝礼」など無いのだが、Vorkswagen財団からの助成金で講師謝礼を出すと言われて、ドイツマルクの札束を想定外に受け取った。そこで筆者はベルリン市内の楽器店に行ってその全額でゲットしたのが、立派なBass Recorderだった(→伏線[C])。

2-2. SUAC MAF

2年前からカリキュラム構築に参加して、2000年4月に開学した静岡文化芸術大学(SUAC)の教員を兼職することになった筆者は、翌2001年に「学長特別研究」として「SUACメディアアートフェスティバル(MAF)」(音楽情報科学研究会・夏のシンポジウム併催)をプロデュース/開催し、このMAFはその後10年間続いた。MAF2001[16]ではライヴComputer Musicコンサートとして2夜連続で「赤松正行・東野珠実・中村滋延・志村哲・岡本久・小坂直敏」・「菅野由弘・水野修孝・吉田靖・長嶋洋一・矢坂健司・莱孝之」(敬称略・出演順)の各氏が公演した。東野さんは笙ブレスセンサによりライヴ映像/音響を駆動する作品"I/O"を公演し、筆者は次項「渡欧ツアー」のために作曲した、13弦箏/17弦箏をライヴサンプリングして「自身の残像音響と競演する」作品"tegoto"[17]を初演した。東野さんの高崎音楽祭での凱旋公演[18]に筆者が協力したり、SUAC「瞑想空間」プロジェクト「靄夜(もや)」[19]や特別講義などに来てくれた東野さんは、MAF2001で筆者の"Visional Legend"を再演した。伏線[B]から繋がって、MAFと共に2001年には「渡欧ツアー2001」があった。Kasselで国際会議を主催するJohannsen教授から「日本の伝統音楽家を招待したい」との打診を前年に受けた筆者は、「尺八大師範・三好芫山さん、箏/三弦・三好晃子さん、笙・東野珠実さん」と共に和楽器店「琴傅」12代目当主(邦楽器のメンテナンス)までを含めたグループを組織し、3都市3公演2講演の渡航文化交流(パリ・カッセル・ハンブルク)計画を国際交流基金に申請して受理された[20]。パリ・スタジオCCMIXおよびドイツでの国際会議「Human Supervision and Control in Engineering and Music」[21]において筆者は東野さんのデモを伴いつつ講演[22]し、ドイツでの計3回のコンサートでは、前半で三好芫山・三好晃子・東野珠実の3氏が日本伝統音楽を披露し、後半では筆者も加わって「コンピュータ+伝統楽器」の公演を行った。具体的には前半「Japanese Traditional Music」では、"Tsuru no Sugomori" (Shakuhachi solo) - composed 500 years ago、"Midare" (Koto solo) - composed 350 years ago、"Hirajyo no Choshi" (Sho solo) - Traditional Gagaku、"Ichikotsu" (Shakuhachi and Koto) - Traditional、の4曲を演奏し、後半「Expanded Traditional/Contemporary Music」では筆者の作曲である、"Bio-Cosmic Storm II" (BioSensor and live Computer)、"Visional Legend" (Sho, Graphics and live Computer)、"tegoto" (Koto and live Computer)、"Japanesque Germanium" (all 4 players)、の4曲[23]と共に、途中で大師範・三好芫山さんの尺八即興"Getsuro" (Shakuhachi solo)も演奏した。

渡欧ツアーの翌2002年に筆者は再びMAF2002[24]をプロデュースして、ライヴComputer Musicコンサートとして2夜連続で「由雄正恒・中村文隆・岡本久・平野砂峰旅・長嶋洋一」・「佐近田展康・赤松正行・三輪眞弘・東野珠実・後藤英・Joshua Kit Clayton」(敬称略・出演順)の各氏が公演した。東野さんは2002ver.の作品"I/O"を公演し、筆者はBass Recorder(←伏線[C])を演奏してライブに音響/グラフィクスを変容させる作品"Berlin Power"[25]を初演した。このMAF2002ではIAMASの全面協力のもと、Max+MSPを拡張させる「jitter」の開発者でありアーティストのKit Clayton氏が来日して、国内の数十人の「Max使い猛者」がSUACに集結し、世界に先駆けて開発者本人の解説で発表されるという「DSPSS2002」も開催した[26]。jitterが世界に向けて発表されたその日のコンサートで、jitterを活用した作品が公演される前代未聞の出来事は、開発者自身が作曲/出演したからこその事である。ちなみにこのMAF2002に向かう1ヶ月の間に、筆者はMaxを活用して宇宙人音楽(→オーケストラ出演)や人体音楽(→ラジオCM受賞)も作曲/公演していた[27]★。

東野さんの活動は「ヨー・ヨー・マのWorld Tour」の一部を担当したりして海外でも評価され、翌年1月には東野さんのニューヨーク公演に招待され同行してコンサートスタッフとして協力し、さらにプリンストン大学やジーメンス研究所も訪問した[28]。その2002年に筆者が水面下で進めていた活動は、ICMCの「新楽器」関係者やACMの「HCI」関係者が前年にワークショップとして開催し、2002年から国際会議となったNIME(New Interface for Musical Expression)コミュニティからの打診を起点とする。かつて1999年に、情報処理学会音楽情報科学研究会チュートリアル「Sensor@ComputerMusic」[29]で筆者と共に講師を担当したのが、かのBIOMUSEの生みの親、Atau Tanaka氏である[30]★。同氏が拠点の一つとしたのがパリのIRCAMであり、そのIRCAM契約音楽家/研究者である後藤英さんとは1995年頃からずっと交流があり[31]、いつもICMCの海外で再会し、MAF2002/DSPSS2002にも来日参加してくれた(→伏線[D])。

2-3. NIME2004

翌2003年に筆者は「情報処理学会音楽情報科学研究会(SIGMUS)」と「インターカレッジコンピュータ音楽コンサート(IC2003)」と併催のMAF2003[32]をプロデュースしたが、その裏で約1年をかけて翌年のNIME2004[33]に向けて準備を進めた。本稿において主流から逸れた支流のため詳細は省略するが、最終的には外務省・文化庁・国際交流基金の公的「名義後援」を受け、それを元にローランドとヤマハから財政的支援を取り付け、さらに多くの助成/後援を申請獲得して、開催の概要が決まった。筆者は5月のNIME2003(モントリオール)では研究発表[34]と作品公演[35](←伏線[C])の両部門で採択されて発表しつつ、最終日の壇上では大会委員長として「来年、日本(SUAC)においで下さい」と招致演説を行った[36]。ちなみに同じ2003年の10月にはICMC2003(シンガポール)で2件の研究発表[37]★(ヤマハからの受託研究→米国登録特許の筆頭発明者)も行っていた。話が前後するが、ここまで登場していない木村まりさんに関して、ここで一時的に話は1991年に戻る。筆者がまだKAWAIにいて、技術士[情報工学部門]を取得してオフタイム技術士として「二足の草鞋」となった年であり、翌1992年には技術士[電気電子部門]も取得して、翌1993年に退社独立するまでの期間である。それまでの欧州と北米での開催から拡大して、初めてICMCがアジア・日本で開催されたのがICMC1993(東京・早稲田大)だったのだが、筆者は任意団体時代の音楽情報科学研究会で知り合った作曲家・中村滋延氏と交流して、中村作品のためのシステムを製作した[38]。その中村作品がICMC1991(モントリオール)に採択されてサポート「出張」参加したのが筆者にとって初めてのICMCだった。翌1992年は、筆者は業務外の個人的研究が採択されてICMC1992(サンノゼ)に発表参加し[39]、さらにICMC実行委員会として、日本国内の音楽情報科学研究会メンバーと、当時シリコンバレーに行っていた平賀譲さんが頻繁に連絡を取り合いながらICMC1993の準備を進めた[40]★。そのICMC1991〜ICMC1993の会場で筆者が知り合ったのが、バイオリン奏者・作曲家の木村まりさんである。今回、本稿執筆のために過去のデータを探索して、「1993年2月末」に製作/プレゼントしたマシン(MIDI入力に反応してLEDバーグラフの「針」が振れるメトロノーム)のZ80ソースコードを発掘した。筆者にとって木村まりさんは「ICMCのたびに現地でだけ出会う、海外で活躍する音楽家」であり、上述の東野珠実さんのように具体的なコラボレーションは無かったものの、筆者にとっていつもICMCやNIMEなどの場で顔を合わせるスター/友人だった。

そして話は10年後に戻る。モントリオールNIME2003で翌年の日本招致演説をした筆者は、カンファレンス業者に頼らず、内外全ての参加登録registrationを受け付け、来日参加者のホテルを全て手配し、期間中の参加者用インターネット専用回線をNTTと契約し、SUACのMAF2004[41]をNIME2004[33]と合体させる計画を立てた。基調講演には、MediaLabの紹介でRobert Moog博士(テルミンやMoogシンセサイザーの生みの親)と、国内からメディアアーティスト・岩井俊雄氏という豪華なダブルゲストも決まった。せっかく海外/国内から多数(各200人ほど)の専門家が浜松に来るということで、NIME2004本体3日間の前日「ヤマハ豊岡工場」(管楽器)・「カワイ竜洋工場」(ピアノ)を巡るバスツアーと、翌々日「ローランド研究所」・「ヤマハ本社ピアノ工場」を巡るバスツアー2件も設定した。コンサートセッションではSUAC講堂ホールだけでなく、浜松市内のクラブでのDJライヴも手配した。そして翌日にはSUAC企画として「MAF2004 Open Lecture Concert」を構想して、ここに筆者がゲストとして招待したのが、上述の木村まりさん、伏線[D]の後藤英さん(IRCAM)、そして東野珠実さん、という3人だった。MAF2004のページ[41]に筆者が書いた「内容」は以下である(→この中に伏線[E]があった)。

筆者と後藤さんはNIME2004では研究発表、東野さんは筆者と共にNIME「オープニング/基調公演」セッション冒頭の即興演奏(Opening Performance)[42]★、そして木村まりさんはNIMEコンサートで自身の作品"GuitarBotana"を公演した。NewYorkのチーム"LEMUR"が開発した「音楽演奏ロボット」(NIME2004にて研究発表)を従えて、まりさんのバイオリン音響を聞いて追従反応するMaxパッチが駆動するロボットとの競演は、「NIME/ICMCでの語り草」となった伝説的名演である。前日リハーサル中に振動する共振ポイントをまりさんが強調すると、激しく揺れたロボットの鉄骨が折れてしまい、慌ててSUAC金属工房で溶接する一幕もあった。今回、万博プロジェクトで再会した本人の口から明確に許諾を得たので、20年前の"GuitarBotana"の記録動画をYouTube公開できた[43]が、この公演に匹敵する緊張感/完成度のパフォーマンスを行える作曲演奏家はおそらく、現在も木村まりさん本人だけであろう。メディアアートの領域で活動する司会者(長嶋洋一・デザイン学部助教授)が、それぞれ交流・コラボレーションしてきた、いずれも海外で活躍する若い芸術家を紹介します。 後藤英さんはパリの国立研究機関IRCAMなどを舞台に活躍する作曲家/演奏家で、オーケストラからComputer Musicまでの広い領域で作曲、作品公演と研究を続けています。2002年のMAF2002でも来日して作品を公演してくれました。今回のコンサートでは、世界に一つのオリジナル楽器Virtual Violinによる作品と、来日したダンサーMie CoquempotさんのBodySuitによる作品の2作品を公演します。木村まりさんはニューヨークのジュリアード音楽院で教鞭を取るとともに、バイオリニストとしてはクラシックから現代まで幅広いレパートリーを持ち、さらにComputer Musicの作曲家として多くの作品公演を行っています。特に、世界で一人だけ出来るというサブハーモニクス奏法(弦の本来のピッチのさらに下の音域を任意に演奏する技法)は絶賛されており、このレクチャーコンサートでもその一端を紹介していただけるでしょう。コンサートでは、バッハの無伴奏パルティータと、Computer Music作品の2作品を公演します。 東野珠実さんは雅楽の「笙」の演奏家、そして作曲家として内外で活躍しており、多くの現代邦楽の賞を受賞したり、昨年はヨー・ヨー・マのWorld Projectで新作の作曲を委嘱されニューヨークに滞在しました。SUACでは過去にもMAF2001、MAF2002、そして芸術文化学科の専門科目「現代芸術論」の特別講義をしてくれました。コンサートでは、古典から1曲、そしてオリジナルを1曲、公演します。

今回はNIME04に合わせた機会としてこの3人がSUACに集まるのを機会に、海外を舞台に活躍する芸術家の生きた姿の紹介をまず前半で行います。たまたま昨年は、後藤さんがパリジェンヌを射止めて結婚し、東野さんが出産され、フランス人の御主人を持つ木村さんも2人目を出産されました。家庭、異国での生活、収入のための仕事、そして芸術的創造的活動、をまさに進めているゲストとの本音トークは、SUAC学生にも大きな刺激となるでしょう。

そして後半では、それぞれ作曲家としての作品公演コンサートを行います。(長嶋)

そのNIME翌日のMAF公開レクチャーコンサートの当初プログラムは、「長嶋洋一 : "Wriggle Screamer"」・「木村まり : "サブハーモニック・パルティータ"、"ポリトピア"ヴァイオリンとインタラクティブコンピューターのための」・「東野珠実 : "花調子 (紫陽花)"」・後藤英 : "Continuum" for Le SuperPolm and Interactive Video、"o.m.2-g.i.-p.p." Composition for BodySuit, Sound and Interactive Video」となっていた。筆者は新楽器「光の絃」と筋電楽器「MiniBioMuse-3」を演奏する作品"Wriggle Screamer"[44]を公演したが、この作品は採択されて翌年NIME2005(バンクーバー)でも再演した。さらに当日その場で決めた「東野さん+まりさん+筆者(笙サウンドのライヴKymaエフェクト)」の即興セッションも公演して、我々はComputer Musicライヴの素晴らしさも怖さも知っている「ワンチーム」となっていた。これが今回の万博2025プロジェクトに繋がる最大の伏流となった。ちなみにその後、後藤英さんは帰国して東京藝大・先端芸術の先生になって、現在までMaxコミュニティを先導している。

2-4. 呼吸と身体動作と音楽演奏

万博2025プロジェクトに繋がるメンバー(IRCAMのGerard Assayag氏を除く)は上記NIME2004で揃ったが、さらに筆者と東野さんとのコラボレーションには「呼吸」をテーマとしたものもあった。「笙」という楽器は空気溜まりに繋がった15本の竹管にリードが付いており、指穴を押さえた竹管のリードが呼気と吸気の両方向で振動して鳴る(同時に複数で和音を実現)。ちなみに笙ブレスセンサ(←今回の万博に際して東野さんが「IBUKI」と名付けた)は、リードの付いていない残り2本の竹管のうち1本に空気圧センサ(両方向)を取り付けて、呼気と吸気の両方をシームレスに連続値検出してMIDI送出している[9]。呼吸そのものが音響となる「笙」に魅せられた東野さんは25年前から「呼吸」に注目した活動を継続しており、筆者は1999年にソプラノ歌手とコラボレーションする東野さんの依頼で、歌手の胸部と腹部に伸縮ベルトを巻いて「歌唱の呼吸動作を連続値検出してMIDI送出」する「呼吸センサ」を開発していた[45]。日本音楽知覚認知学会で交流を続けていた帝塚山大学名誉教授・村尾忠廣先生の「逆腹式呼吸唱法」研究のために依頼されて、筆者は2016年にArduinoを用いた「3チャンネル呼吸センサ」を開発した[46]。これは原理的には1999年のものと同じ(マイコンがAKI-H8からArduinoになり、出力がMIDIからUSBシリアルになった)ものであり、村尾先生の「逆腹式呼吸唱法」においては腹部の複数の上下位置で別々に呼吸動作する事が重要なので、3本の呼吸伸縮ベルトによって3チャンネル化したものである。この動画を東野さんに紹介して、後述の「舞楽」センシングのために久しぶりにこのセンサが活躍することになり、伏線[E]と繋がって今回の万博2025プロジェクトにおいて重要な役割として再登場した。

なおIRCAMのGerard Assayag氏については万博2025でほぼ初対面だったものの、筆者はNIME2004の翌月からSabbatical[47]でパリに2ヶ月滞在して、IRCAMに帰った後藤英さんを訪問したり、IRCAMの専門家を前にしてレクチャー「Interfaces for Interactive Media Art」を行ったりして、IRCAMは「お馴染み」の場所となった。そして2年後にNIME2006[48]はIRCAMを会場として開催されたが、木村まりさんはここでもバイオリン音響/バイオリン演奏動作のテーマセッションのデモ奏者として大活躍した。バイオリンの演奏というのは姿勢とボウイング(弓の操作)が特徴的であり、これはまりさんが現在まで研究協力している「MUGIC」システム[49]に繋がっていくという意味で、今回の万博プロジェクトへの伏線[F]ともなった。

3. 大阪・関西万博2025プロジェクト

3-1. プロジェクトの準備

万博というのは国家事業であるが全体としてのパビリオンやインフラ整備までであり、個々の万博イベントの中身はそれぞれが企画し実施するものなのだ、というのを痛感した。人間国宝や宗家・家元など伝統芸能の著名人が「発起人」としてずらりと並ぶ[1]ところまでに時間がかかり、具体的に「何をするか」が全く見えないまま「直前まで白紙状態」というのがほとんどのようである。筆者が万博に関して東野さんから依頼(打診)を受けたのは2024年9月であるが、OKしたものの次に「経済的な問題で難航中」というメイルが届いたのは12月末、そして1月に東野さんが運営本部に企画プレゼンしてOKになったらしく、2月末に関係者入館証(AD証)の登録をするようにとの連絡が届き、筆者が関係者として登録されたのは万博が開幕する2週間前の4月初旬であった。当初の東野さん企画では16世紀から続く国内某老舗企業やNTTデータ(新・生体センサを発表?)もプログラムの一部だったのだが、最終的には某企業は事情があって撤退、NTTデータも「活動紹介movieを見せるだけ」と縮退した。ボストンでのICMCに向かう途中で来日する木村まりさんとGerard Assayagさんは6月3日の「Breathing Media Projects 〜Body as Traditional Media〜」というコンサート出演のみ、そして6月6日のレクチャー/デモは筆者と東野さんとNTTデータ、となった。そして重要なメンバーとしてもう一人、伊藤光波子さんが登場し、両日とも一緒に「出演」する事を知った。MAF2004 Open Lecture Concertの資料に筆者が書いた「東野さんが出産」という伏線[E]から繋がるのが、ここに登場した東野さん次女の光波子さんであり、5歳の頃から「舞楽」(奈良時代〜平安時代にかけて天皇や貴族が楽しんだ「舞」のこと。「舞」をいろどる音楽が「雅楽」)を舞ってきた、若きベテランである。東野さんの企画構想として、「笙」の演奏だけでなく、木村まりさんが活用/紹介している「MUGIC」[49]や筆者の呼吸センサを装着した伊藤光波子さんの舞楽、というのもプログラムの一つの柱となった。

「伝統文化未来共創Project」企画の会場は、EXPOホール"シャインハット"、ギャラリーEAST、ポップアップステージ南、という互いに隣接する3つの建物であり、「シャインハット」は巨大なホールでメイン企画「令和今昔四季物語絵巻」のステージ、また「ポップアップステージ南」は屋外の吹き抜け舞台であり、雨天の場合には東野さん企画を行う「ギャラリーEAST」に演目が割り込んでくる・・・と知って驚いた。この「ギャラリーEAST」は正方形の一つの隅が楽屋に削られた五角形のような建物で、後方には国内各地の名産品の物販コーナーがあり、ステージは「47都道府県大黒柱プロジェクト」[50]★★によって全国から集められた「束ね柱」で作られており(当日朝に会場入りしてみるとまだ柱の汚しステイン塗装中)、そのステージ最前部には万博1970で展示された樹齢1000年の盆栽(55年前に1億円)[51]が鎮座する、というものだった。担当者とのZOOM会議でステージ配置を相談したと思ったら翌週にステージの場所が反対側に移動する、などというドタバタは5月まで続いた。「ギャラリーEAST」は基本的に展示空間なので「照明」は天井の固定ライトのみ、プロジェクタが見当たらず探したり、スクリーンが無くて隙間に壁面投射したり、音響スタッフは万博期間中あちこちのイベントを担当するたった一人のミキサー操作、という、まさに「学園祭」的ノリの修羅場だった。Computer Musicコンサートというのはそれでなくてもトラブルが怖いのだが、筆者の経験としては過去35年間で最も劣悪な公演環境であり、両日とも実質的にリハーサル無しで本番に向かうことになった(最初に結論を書いておくが、筆者としては今回の公演は「1勝1敗1引分」)。

3-2. 公演の準備

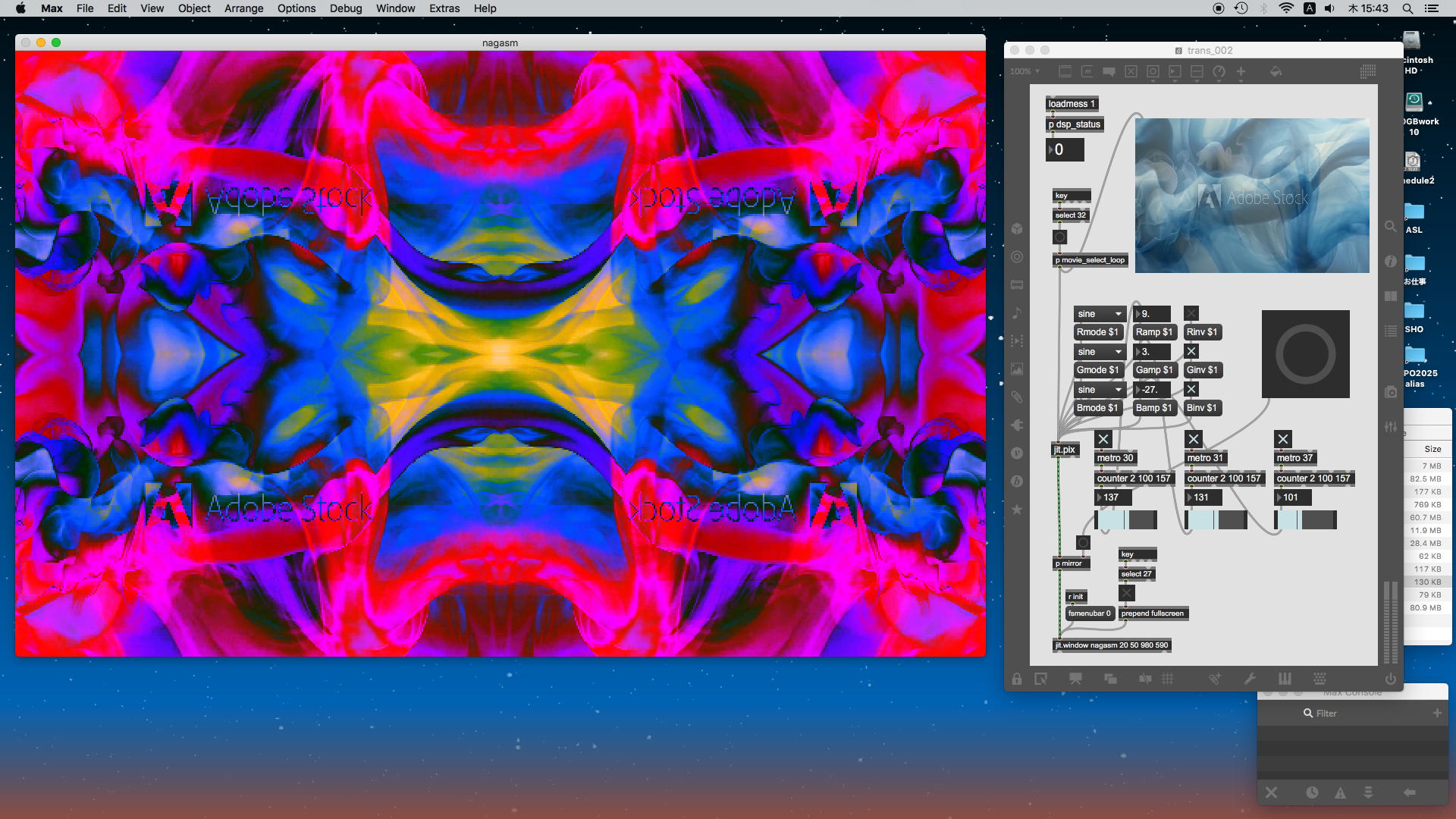

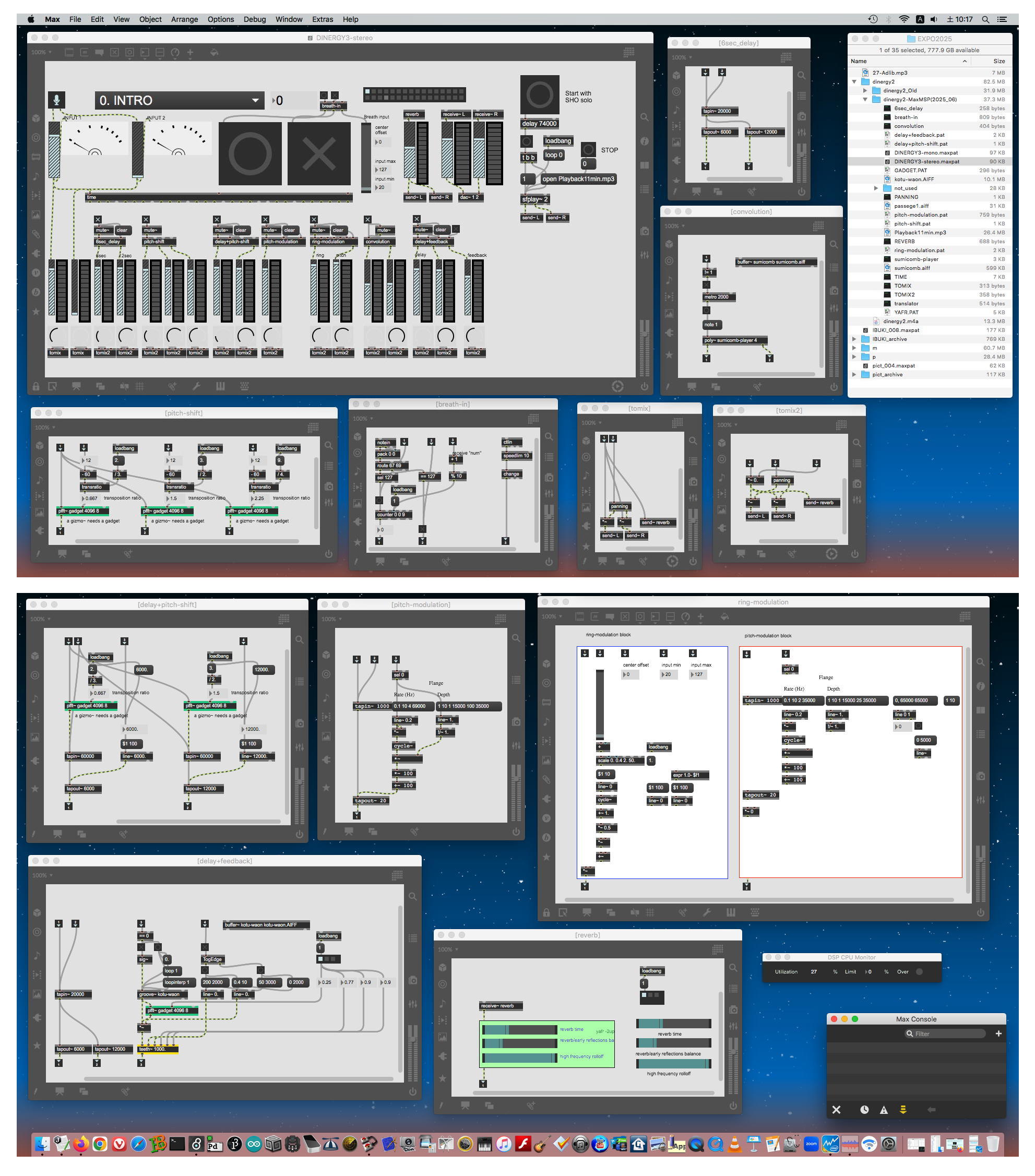

本番まであと2ヶ月という4月初旬の東野さんメイルで筆者が初めて知ったのは、メイン公演として伏線[A]の"dinergy2"を20年ぶりに再演するという方針だった。この作品は当初1998年には笙サウンドのライヴ処理にKymaを使っていたのだが、詳細不明ながら2005年頃に東野さんとIRCAMとのコラボレーションによって「Max/MSP」版に改訂されたらしいMaxパッチがあった。宅急便で送られてきた笙ブレスセンサ"IBUKI"からのMIDI情報を受けてこのパッチが動作する事を確認したが、コンピュータ環境(中核CPU、OSversion、ソフトversion)が劇的に変化するなか、20年前のパッチをMajor Versionが5ステップも上がった現在バージョMaxが上位互換で読み込んでそのまま走らせることが出来る、というだけで特筆に値する。ただし、ファイル拡張子など各所が大幅に変更されているために、パッチの読み込みにちょっとした工夫(経験則)が必要だったので、初心者は問い合わせされたい。今回はこの2005年version"dinergy2"に、筆者がプログラミングしてライヴ・グラフィクスを加えた改訂版"dinergy3"に進化発展させる事になり、「サウンド部分は既存のIRCAM版パッチを絶対に変更しない」・「jitter/GENによって演奏に対応したグラフィックをライヴ生成する」(操作はステージ袖で長嶋が即興する)、という方針が決定した。筆者はちょうど、SUACでの最終イベント/公演に向けて、jitter/GENを駆使したMaxプログラミングでのライヴ・グラフィック生成に取り組んでいたので[52]★★、格好の「思い出し」題材となった。ただし、「作曲・東野珠実」である作品に割り込む事を避けるために、グラフィック素材としてAdobeの素材集から東野さんがイメージに合致・購入したものの提供を受け、基本的に東野さんの"dinergy2"の楽譜[53]の構想を最大限に尊重した。

作品"dinergy2"では、冒頭に東野さんの笙の即興独奏から始まり、70秒ほどしたところで、あらかじめ笙や雅楽の素材を使って作曲された背景電子音響パートがCD再生スタートし、基本的にこの固定時間に従って音楽が進行する。部分的にはIBUKIのマイクロスイッチによってシーン推移を制御するものの東野さんはこの背景音響を聞きながら即興を交えて笙を演奏して、その笙サウンドがMax/MSPによって色々なエフェクトを受けるという構造であり、ラストは背景電子音響パートが消えつつ最後の笙即興に繋がって、「生の」笙サウンドが静かに消えていき演奏が終了する。そこで筆者はまず、電子音響パートCDを最高品質mp3ファイルに変換して、冒頭の東野さんの笙の即興独奏スタートと同時にMaxボタンをクリックして、70秒後からmp3再生を行った。「単なる背景movieの再生」(これでは単なるカラオケ)を避けるために、ライヴ・グラフィックのパートは素材movieをシームレス/エンドレス再生するjitterモジュール群で生成して、それらのミックスやGENエフェクトは全て、楽譜を見つつ東野さんの演奏を聞きつつ筆者がマウス操作することにした。これにより、公演のたびに毎回、細部では異なった演奏が実現される。本番まで一度も実際に会うことは無かったが、約1ヶ月間のメイル交換(打合せ)と共に何度か試作して、最終的なバージョン(東野さん笙演奏音源の代替として、1998年の「SFC録音[笙]音響素材」★から抽出したアドリブ演奏をmp3化して再生し、これをMax/MSPでサンプリングして信号処理)の試作バージョン[54]を「こんな感じです」と東野さんに連絡したのは5月25日、つまり本番の1週間前だった。このMaxプログラミングの詳細については次節にて詳解する。

6月3日コンサートのプログラムのうち、東野さんの"dinergy2"は上述の通りであり、「東野+まり+Gerard」パフォーマンス(基本的には雅楽テイストで、東野さんの笙即興にまりさんのバイオリン即興が加わり、さらにGerardさんの「AIプログラム」によるライヴ生成BGMが絡む)については、筆者は完全にノータッチとして仕事を切り分けた。6月6日のレクチャーではまず、笙センサ"IBUKI"により円環状の画像を回転させつつ東野さんの笙サウンドに"dinergy2"とは異なる長嶋オリジナルのエフェクトを加えるMSP/GENパッチも制作することになった(このMaxプログラミングの詳細についても次節にて詳解)。さらにもう1曲、当初はNTTデータから提供される予定の新・呼吸センサを装着した伊藤光波子さんの舞楽のための音響/映像として何か出来ないか、というリクエストも受けた。最終的にこのNTTデータ呼吸センサは幻となったのだが、呼吸センサを装着した光波子さんの舞楽を、一種の「呼吸ビジュアライズ」デモとしてお披露目する可能性があるということで、筆者のArduinoを用いた「3チャンネル呼吸センサ」[46]も大阪に持参して、このパッチのセンサ情報グラフ化でも最低限のvisualizeになっているので、あとは大阪に行ってから考えることになった。

会場のPA周りの配線図案は、アメリカの木村まりさんとフランスのGerardさんから次々にリクエストが届いては修正して連絡する、という綱渡りも大阪行きの直前まで続いた。そして5月下旬になってまりさんから届いたのは、この「Breathing Media Projects」のチラシ[55]だった。今回の万博には、まりさんの娘さんも一緒に来日し、このチラシはその娘さんと友人でデザインしたとのことで、またまた伏線[E]で筆者が20年前に「木村さんも2人目を出産されました」というそのお子さんだった。これで、東野さんとまりさんとだけでなく、乳児時代の写真だけ受け取っていたそれぞれの娘さんたちとも会えることとなり、この万博プロジェクトが色々な「縁」「伏線」の集大成のようになってきた。このチラシはさらに当日になってみると、東野さんが2日間でリモート自主制作して会場で配布した立派なリーフレット[56]の表紙も飾ることになった。結局、本番前日の6月2日に大阪入りした筆者は、今回の2回のコンサート/レクチャーのプログラム(何をするのかの全体像)を全く知らなかったのだが、実は色々な情報が不足して東野さん自身も最終決定できておらず、メンバー全員がプログラムを知ったのはそれぞれ本番当日朝の東野さんメイルによってだった。

3-3. プロジェクト本番

万博会場「夢洲」駅まで地下鉄を1回乗り継いで30分ほどで行ける「長堀橋」駅に近くにそれぞれ宿を取った我々は、東野さんのホテルのロビーで合流したが、そこで初めて、東野さんがレクチャーで現物を紹介/演奏するスペシャルな「笙」を知った[57]。これは現代の名工・當野泰伸氏が手作りしたチタン製リードの笙を塗装し輪島漆芸の小西綾野氏が蒔絵を施した「星筐(Hoshigatami)」であり[56]、さらに6月6日のレクチャー本番では、當野氏によるこちらも世界唯一の「象牙製の笙」も紹介/演奏された[58]。いざ前日にリーフレット[56]を受け取ってみると、メンバーに弓馬術礼法小笠原源流31世守家の小笠原清基氏が載っているのが不明だったが、6月3日のステージの冒頭に登場して、その場でステージ上で弓を放つ腕に「MUGIC」(←伏線[F])が装着されていて、そのデータで木村まりさんがサウンド生成とスクリーンCGを変化させる「デモ」となっていたのは、当日その現場(ステージ袖)で初めて理解した。普通のComputer Musicライブコンサートであれば、ステージの奥にスクリーンがあってグラフィクスが投射され、さらにステージの左右にはPAスピーカが並んで、ミキサー卓は客席中央の一部に配置されるが、このような一般的な環境とは程遠いものだ、と当日朝に現地集合して覚悟した。まだ柱を塗装中だったステージ袖[59]にテーブルを並べて機材を準備したが(その隣にミキサー卓)、サウンドチェックどころかまだプロジェクタも到着しておらず、スクリーン代わりの壁面(ポップアップステージ南の出演者控室スペースとの仕切り)の場所も未確定だった。全てのスタッフはbestを尽くしていたので本稿では詳細省略するが、結果として"dinergy3"の初演は成功しなかった。HDMIスイッチャ経由でプロジェクタに送っている肝心のスクリーンは出演者から見えず、結果として筆者はライヴ中にあれこれ苦闘した末にスイッチャでスクリーンをBlackに切り替え、ミキサーにアイコンタクトしてサウンドを絞ってもらい、「MaxがクラッシュしたMacBookを公演中にリブートする」という初めての経験となった。東野さんは、背景音響パートのみが聞こえて自身の笙サウンドへのエフェクト音響が鳴らない状況にあっても動じずに凛として演奏を続け(つまりこの時点で背景音響+笙の生音響のみ)、最後まで止めずに演奏を完遂して喝采を浴びた。よく見えない壁面投射もほぼ真っ黒で、筆者の参加はほぼゼロとなったのだが、この公演が「1勝1敗1引分」のうちの「1敗」である。

ただしこの6月3日の「コンサート」全般としては、冒頭に思い付いて笙の即興演奏を披露して客席を温めた東野さん[60]、小笠原清基氏の弓の実演[61]、[まり+東野+Gerard]のセッション[62]、さらに加わった伊藤光波子さんの舞楽[63]、などが次々に進んで、それほど音楽的に専門家というわけでもない満席の来場者(万博観光客)は珍しいパフォーマンスの連続に十分に満足してくれた。ステージ中央の光波子さんの舞楽の身体動作情報を「MUGIC」(←伏線[F])で取得して、まりさんのMaxパッチで生成グラフィクスをインタラクティブに変化させたのだが、ステージから横方向にかなり離れた壁面に投射したので、聴衆は舞楽とスクリーンのどちらかを見る感じになったのが残念だったものの、結果として、プロジェクトの「パート1」全体としては成功したと言える。

海外組が早々にボストンICMCへと旅立ってしまった6月5日の午後は、翌日の「パート2」の準備のため午後に東野さんホテルに集合しての打合せから始まった。複数のソース(長嶋+まり+Gerardの3台のPC)なのに一度もサウンドチェックできなかった「パート1」の音響/映像系のトラブルは、翌日の「パート2」では音源が筆者だけになったので現場で対応できるだろうとの判断で、東野さんの笙即興演奏に長嶋エフェクトが加わるデモンストレーションは、「笙演奏のブレスで画像が回転する」という動作を確認して終わった。そして筆者の持参した「呼吸センサ」[45]を装着して伊藤光波子さんが試みにホテルの部屋で舞ってみて、センサ情報をそのまま単純にグラフ化しても十分である、と確認でき[64]、このBGMには筆者が光波子さんから受け取った雅楽のサウンドを使用することにした。

しかしここで問題となったのが「ケーブルの長さ」である。東野さんの"IBUKI"はMIDIなので5メートルMIDIケーブルを繋いで延長して10メートルもあれば、「笙」という楽器は基本的に移動しないで演奏するので問題なかった。しかし舞楽の光波子さんはステージ内を相当に動き、さらに身体を回転させるマージンも必要なのに対して、3メートルUSBケーブルと用意した5メートルUSB延長ケーブルを繋いでもまったく足りないことが発覚した。しかし大阪の街というのは便利なもので、万博会場よりも近いところに「日本橋電気街」があることに気付き、筆者と光波子さんは地下鉄で「恵比寿町」駅に向かった。ちょうどこの日(木曜日)は電気街の休日だったが、開いていたJoshinで「中継リピーター付きUSBケーブル(20m)」をゲットして、部屋に持ち帰ってテストした筆者は「動作確認OKです」と伝えて翌日の本番に備えた[65]。

そして6月6日に会場「ギャラリーEAST」に着いてみると、PAの機材やプロジェクタなどが何故か大幅に変更されていて、さらにスタンド式スクリーンがステージ横に立つ(盆栽の反対側)ような配置になっていた。スタッフが奔走して、なるべく良好な環境のために努力してくれていたことに感謝しつつ、しかしこの日も簡単なサウンドチェックだけで、とりあえずスクリーン(またまた演者からは全く見えない)にグラフィックが出るところまでを確認して「休憩」(他の企画のステージ本番)をまたぐことになった。我々の出番の前には、同じステージ上を刻々と模様替えしては「落語」・「義太夫」・「きものコンテスト」などの企画が行われていた。

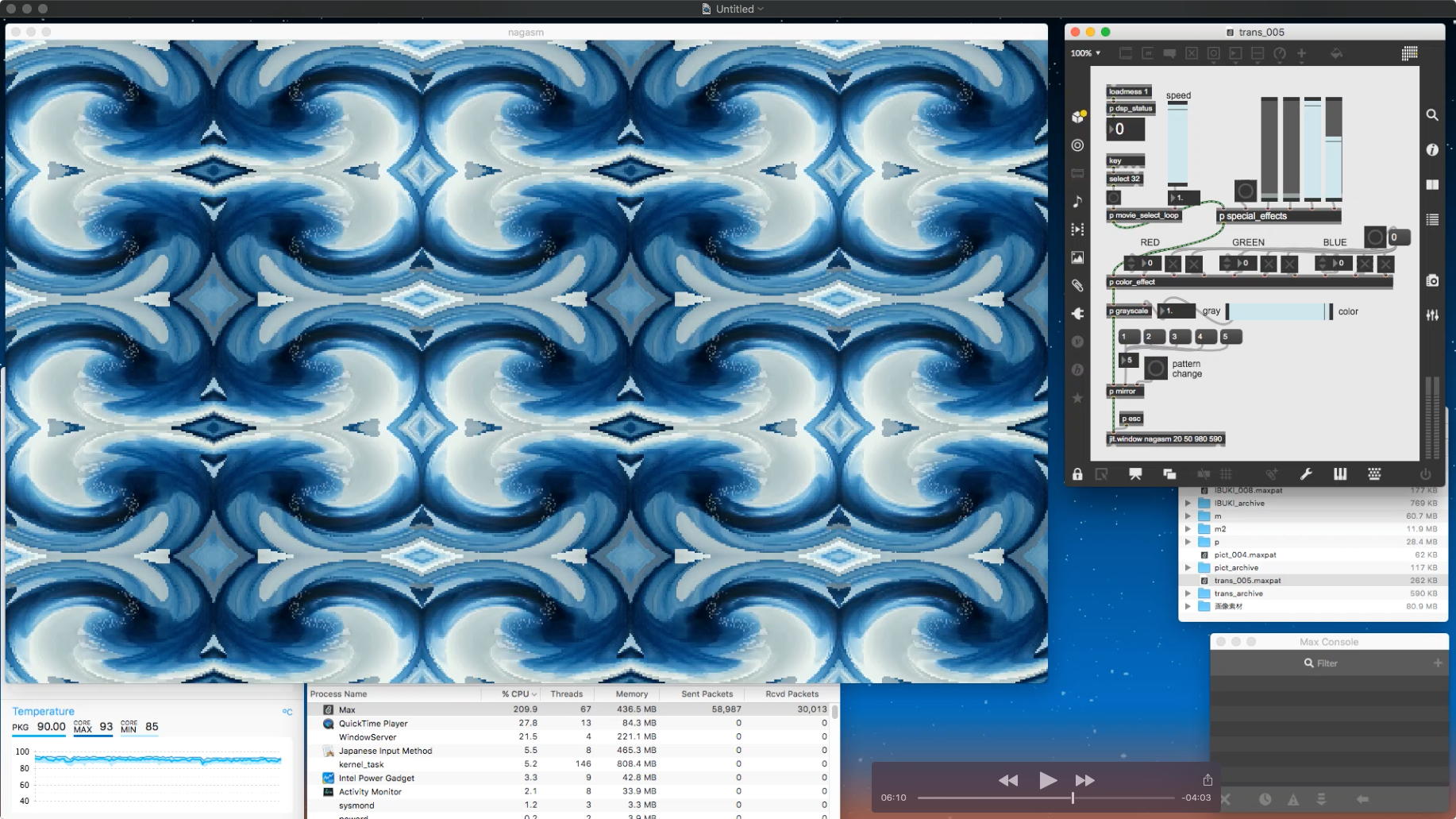

そしてこの日も冒頭に東野さんが笙の即興で会場を引きつけ[66]、さらにレクチャーということでトーク(當野泰伸氏+小西綾野氏で、「チタン製リード+蒔絵」の笙、「象牙製」の笙、を見せて演奏)が聴衆を魅了した。ところが魔物というのはいるもので、東野さんのために作ったMaxパッチ(→次節で詳解)は正常に働いて、笙ブレスセンサ"IBUKI"からのMIDIを受けて最後までグラフィクスは回転してくれたのだが、東野さんが新たに仕入れた肝心の超小型笙マイクからの信号が演奏の途中で突然に断線したように消えて(筆者とミキサーは顔を見合わせたがどうしようもない)、結局、笙サウンドに施される筈だったMSP/GENのエフェクトは前半のみで、後半は途絶えた公演(またまた笙の生音響のみ)となった。 この公演が「1勝1敗1引分」のうちの「1引分」であるが、それでも笙演奏と呼吸のインタラクションが理解され、さらに「生」でも十分に素晴らしい笙の演奏に助けられた。

そしてNTTデータの活動ビデオ紹介というパートがあって、ラストに花波子さんの舞楽の舞いとなり、音楽は雅楽BGM再生なので問題なく、伸縮ベルト式呼吸センサのライヴ可視化のパッチも無事に走った。筆者がステージ袖に置いたカメラでその様子[67]はわかるが、前日のホテルの部屋でのテストに比べて伸縮ベルトセンサの締め付けが甘かったのか、「息を吐く」動作点がかなり高めになって、筆者はほぼライブ中ずっと、scaleオブジェクトの「入力最小値」と「入力最大値」を手作業で補正することになり、表示されるデータもダイナミックレンジがかなり狭くなってしまった[68]。これが 「1勝1敗1引分」のうちの「1勝(100%満足ではない)」となった。しかし来場者にとって、日頃は縁遠い「笙」「雅楽」「舞楽」に触れたこと、さらに世界にたった1管の「チタン製リード+蒔絵」の笙[69]、「象牙製」の笙[70]を間近に見れただけでも素晴らしい体験であり、ここに我々の万博プロジェクトは無事に終わることとなった。

関係者入館証(AD証)[71]★のスタッフは万博パビリオンなどに入館することは出来ず(別途に入場料が必要)、筆者は大屋根リングに登った程度で会場を後にした。詳細不明ながら東野さんはさらにもう1件、「子供たちの舞楽」のような企画もあって最終日の8日まで忙殺されていた。筆者は翌日の6月7日には、1970年大阪万博の記念公園(千里丘陵)に出かけて、事前予約した「太陽の塔の内部」を堪能してきた[72]。1970年万博には小6の時に行ったものの記憶は皆無だったが、今回は55年の時を経て結局、2025と1970の2つの「大阪万博」を体験することになった。

4. Maxプログラミングの詳細

4-1. "IBUKI demonstration"のプログラミング

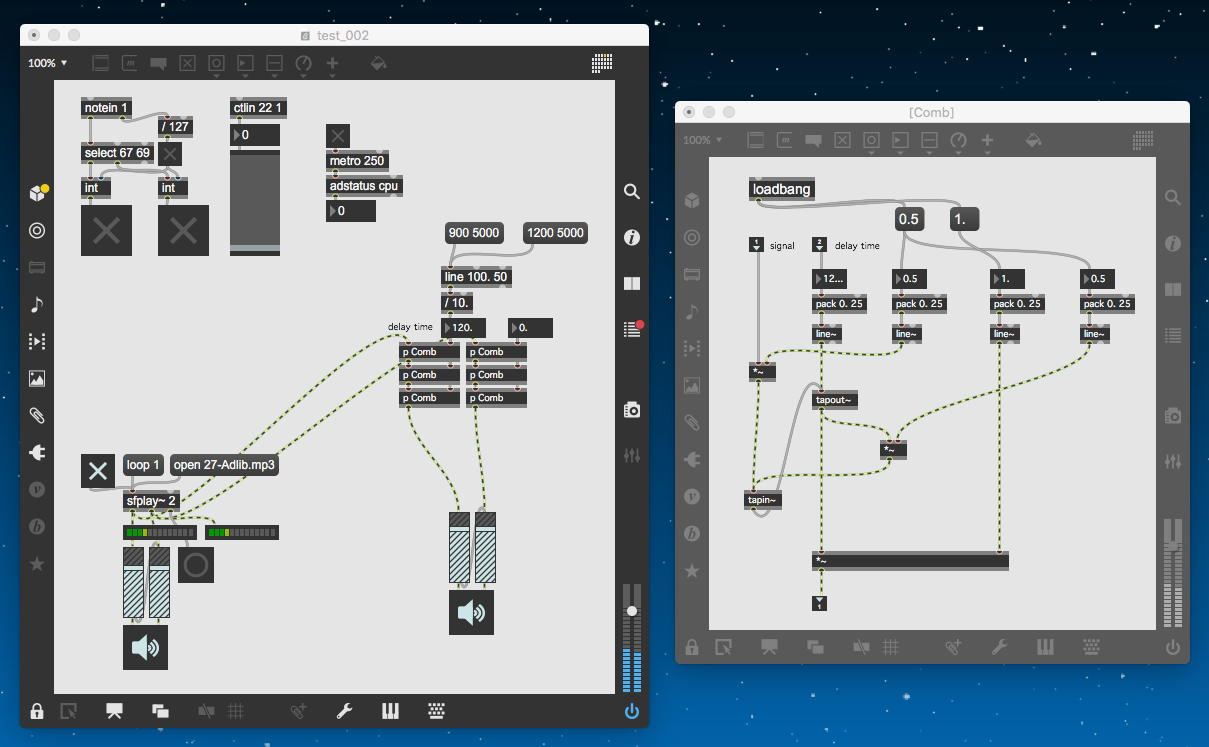

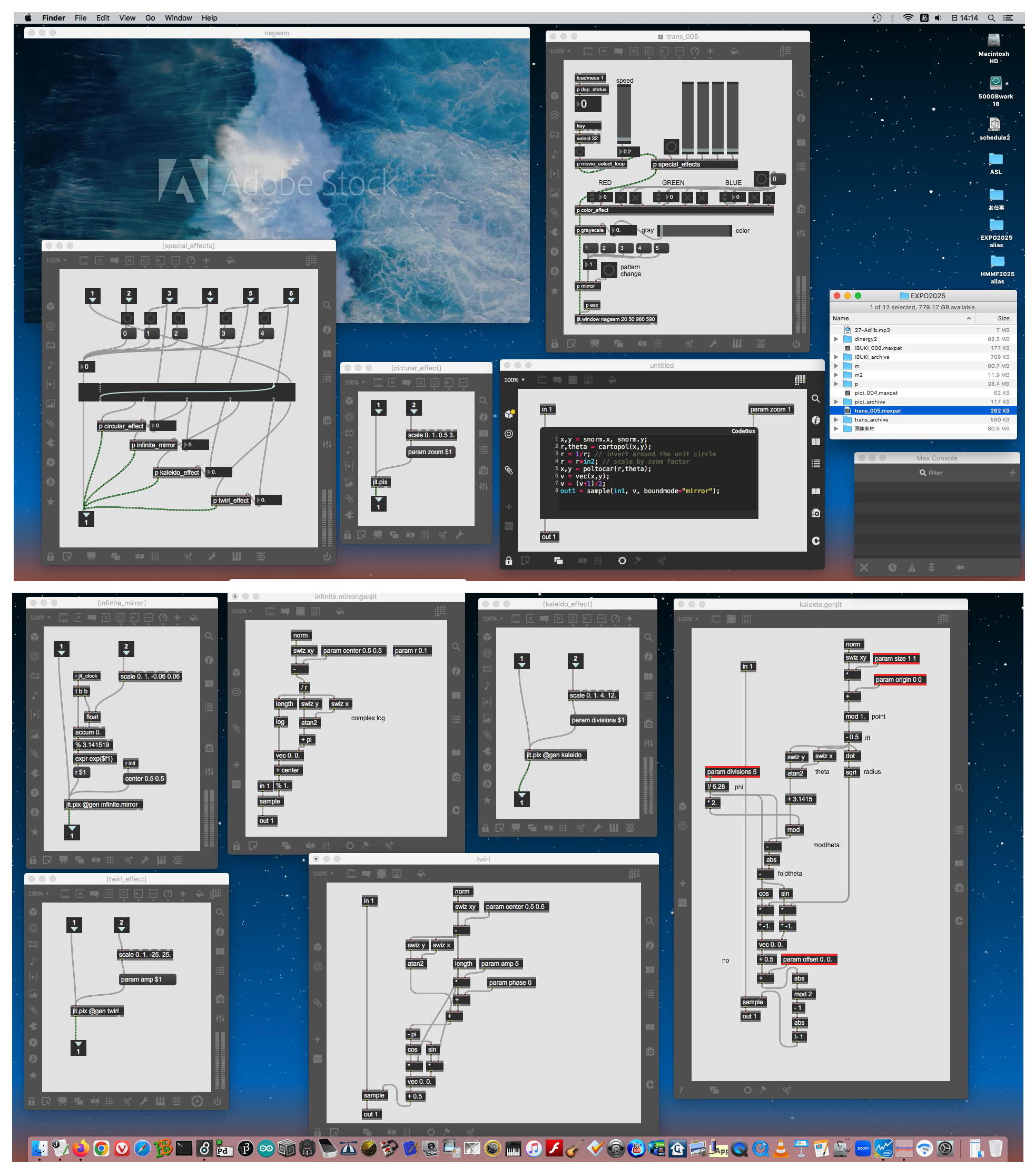

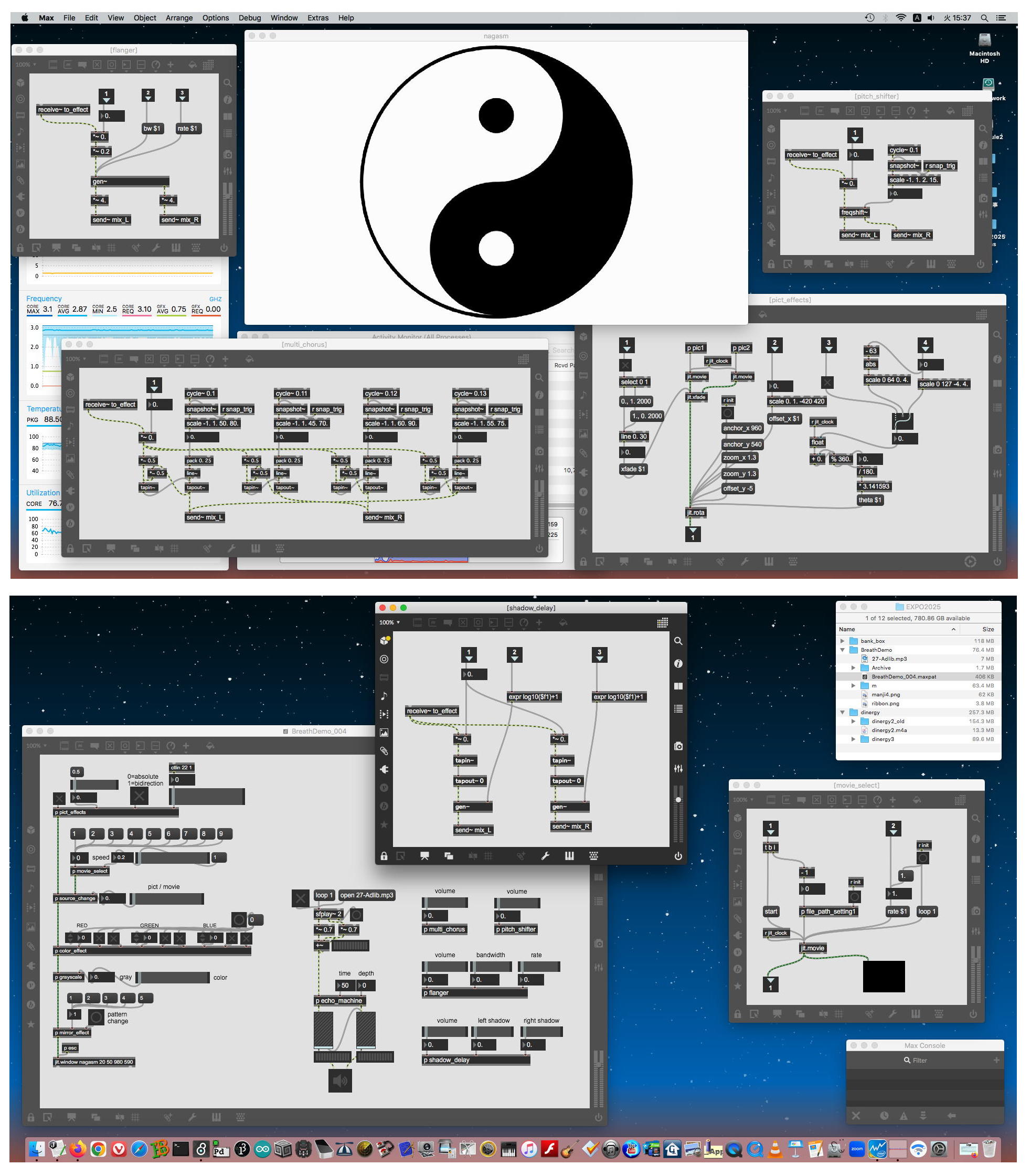

万博の「伝統文化未来共創Project」[1]事務局(消える将来に備えて[73]にローカル保存。ブラウザのテキストエンコードをUnicodeにすると読める)から「関係者入館証(AD証)登録完了」と連絡のあった4月上旬から、筆者は作業を開始した。前述の1998年「SFC録音[笙]音響素材」★を発掘してみると320本ほどのAIFFファイルがあり[74]、東野さんから宅急便で届いた2台の"IBUKI"の動作もMax上で確認できた[75]。"IBUKI"を活用した、欧州ツアー[20]で公演した筆者の作品"Visional Legend ver.2001"[76]★のMaxパッチ[77]を開いてみたが、あまりに複雑で自分でも読み解けないと判明した。そこで320本の東野さん笙サウンドのうちアドリブで約3分間ほど演奏した"27-Adlib.aiff"をmp3化して[78]、これをループ再生した音響を「本番での東野さん演奏」に見立てた音源として、まず図1のようなMaxパッチで櫛形フィルタによるエフェクトを実験し、次に図2のようにステレオのマルチチャンネル・コーラスが良好に実装できると確認して、ここから6月6日のレクチャー"IBUKI demonstration"用に増設して仕上げていく方針とした。その翌日の試作状況[79]★では2画面にまで拡張されて、オリジナルで内部的にGENまで活用したモジュールとして「マルチchorus」・「ピッチshift」・「フランジャー」・「スムースmulti delay」などが実現できた。ライヴの現場では、東野さんの笙サウンドをサンプリングしてこれらのエフェクトをかけて、それぞれのパラメータを筆者が舞台袖で即興的に操作するというシナリオのために、サウンド関係のMaxプログラミングはとりあえずここまでで「完了」とした。

図1 櫛形フィルタによるエフェクトの実験

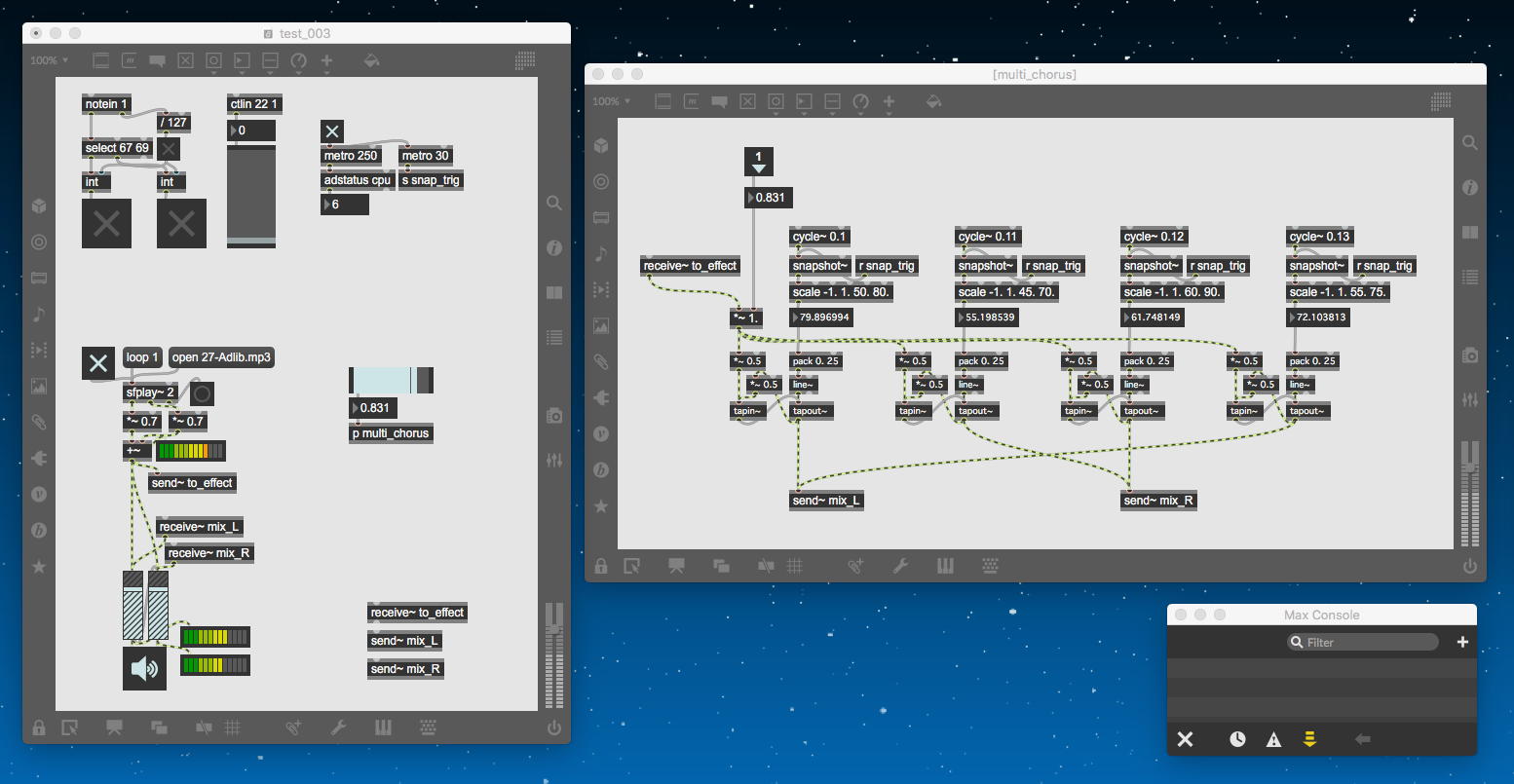

図2 コーラス実装の確認次に必要なのは、"IBUKI demonstration"と"dinergy3"の両方に関係する、ライヴ・グラフィクス生成のMaxブログラミングである。SUACでの最終イベントで筆者が公演した作品"Profound Recursion"[80]★では、jitter/GENを駆使したMaxプログラミングでのライヴ・グラフィック生成といっても、画像素材を使わずフラクタル/カオスのアルゴリズムによって完全に数理造形していたので、今回はやや異なるアプローチとなった。まず最初の実験として図3のように、「フリー静止画素材集(正規購入済)」から390枚の静止画をランダムに選択して、それを曼荼羅のように上下左右対称(元画像を上下反転・左右反転する計4種類の[対称モード]もランダムに選択)で表示する(→フルスクリーン可能)、というMaxパッチ[81]を作ってみた。これらの素材は静止画であるが、曼荼羅のそれぞれがヌルヌルと動き回ると経験上かなり気持ち悪くった経験から、YouTubeで「蛸」「水母」の動画をゲットして適当に切り出した6種類の動画を素材として「ヌルヌル」versionを作ってみると、図4のような感じになった[82]。

図3 曼荼羅っぽい描画の実験

図4 「蛸」の曼荼羅の実験その次に着手したのが、任意のmovieを「シームレス・ループ再生する」というテーマである。過去には動画編集ソフトを使って、(1)対象movieの冒頭をフェードインにする、(2)対象movieの最後をフェードアウトにする、(3)このmovieの中央付近でカットして「前半」と「後半」という2つの動画にする、(4)この「後半」からスタートして、途中ちょっと前から「前半」をクロスフェードしてミックスした動画ファイルを作る、という方法で「Loop再生すると継目が無い」movieを作っていた。これを今回は、長さがそれぞれ異なる任意のmovieを読み込むだけで、再生時には同様の「継目が無いLoop再生」にしたい、というものである。東野さんから最初のサンプルとして届いた動画に対して実験した図5の試作[83]★では結構それっぽくなっていたが、実際には内部的に問題があり、最終的に解決して実際に完成したのはだいぶ後になった(→ 4-4 で後述)。ここまでで、具体的にはさらに東野さんと相談していくものの、"IBUKI demonstration"のための道具立てがほぼ出揃った。

図5 試作Maxパッチの様子

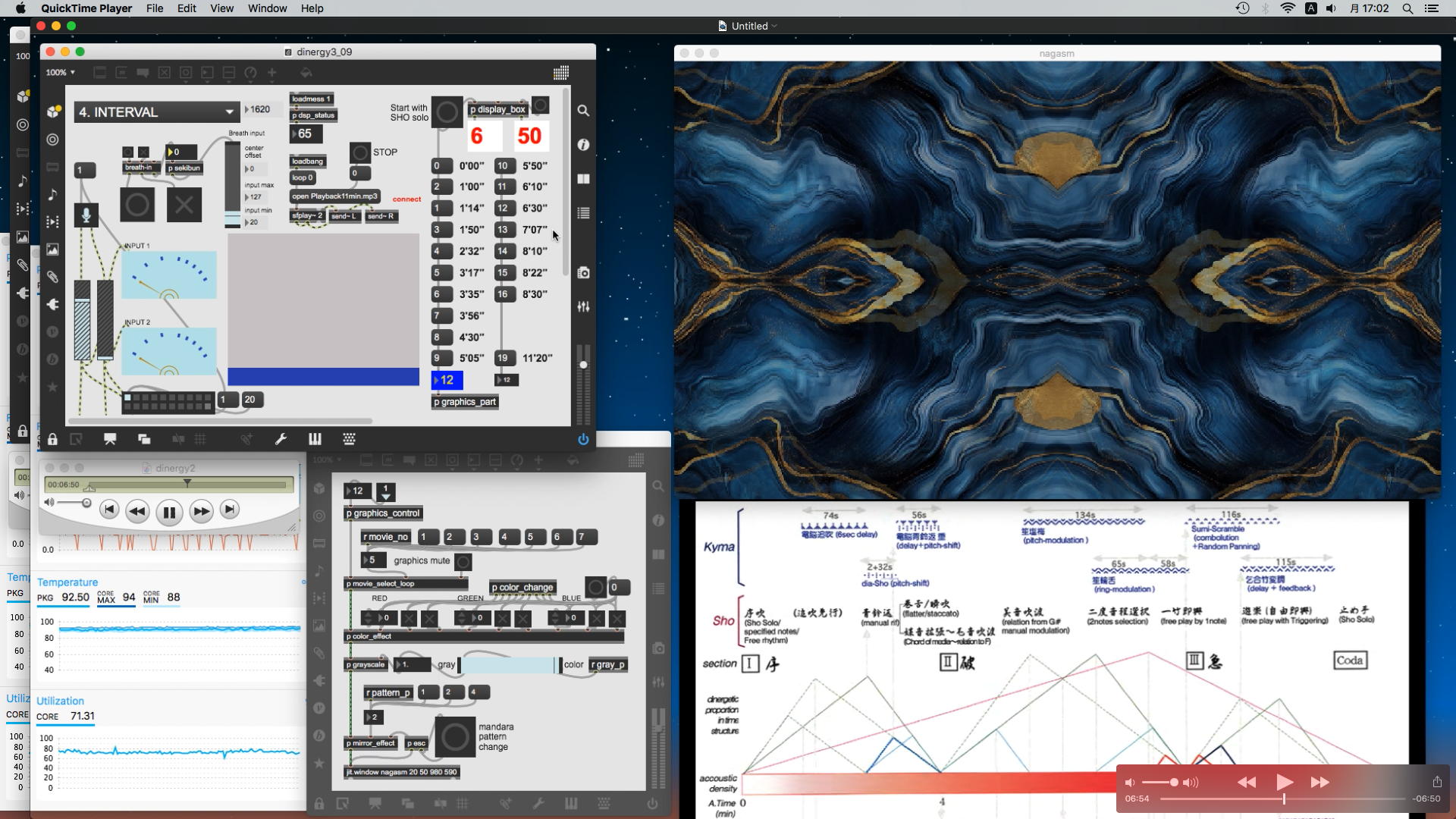

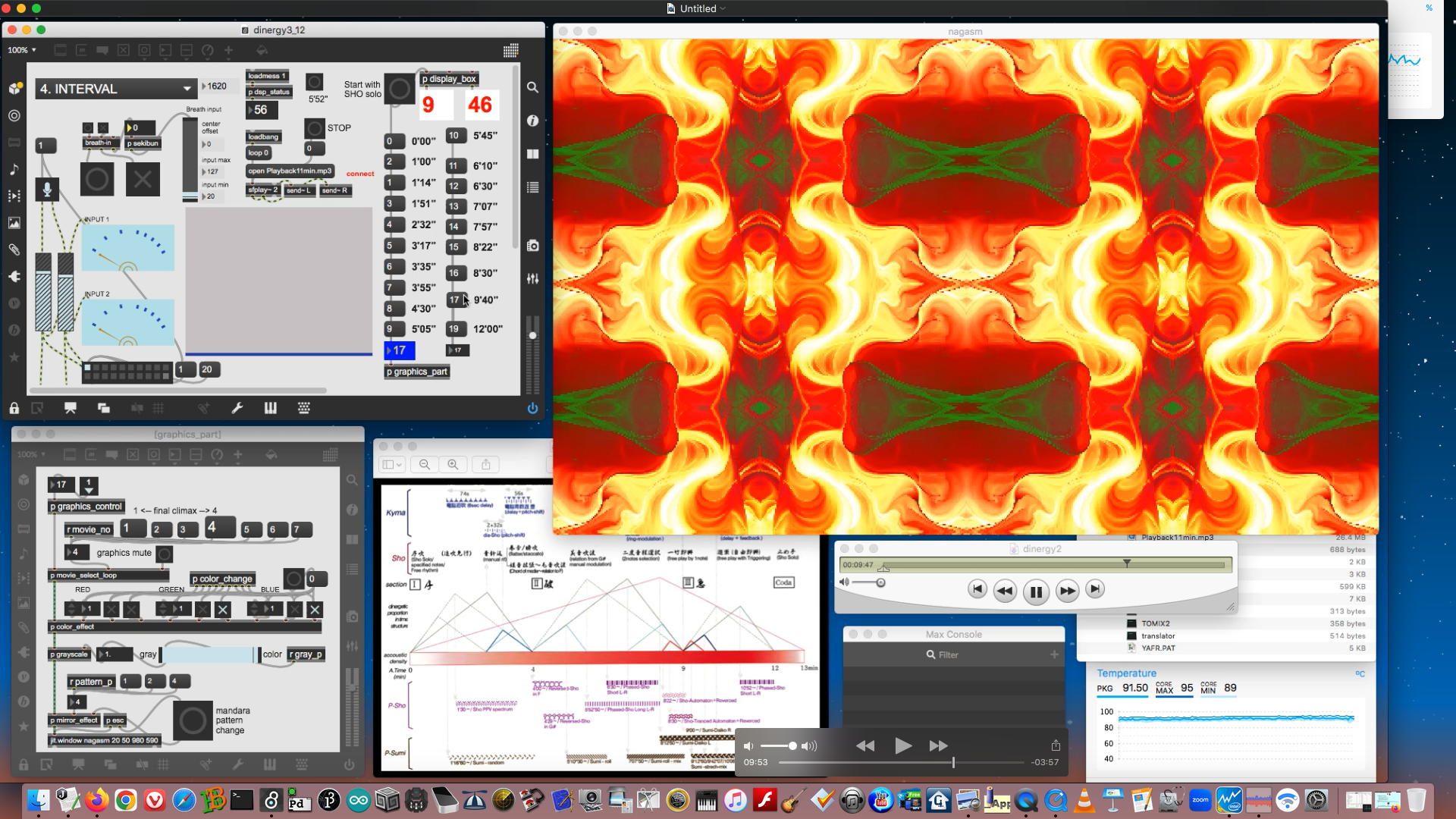

4-2. "dinergy3"のプログラミング

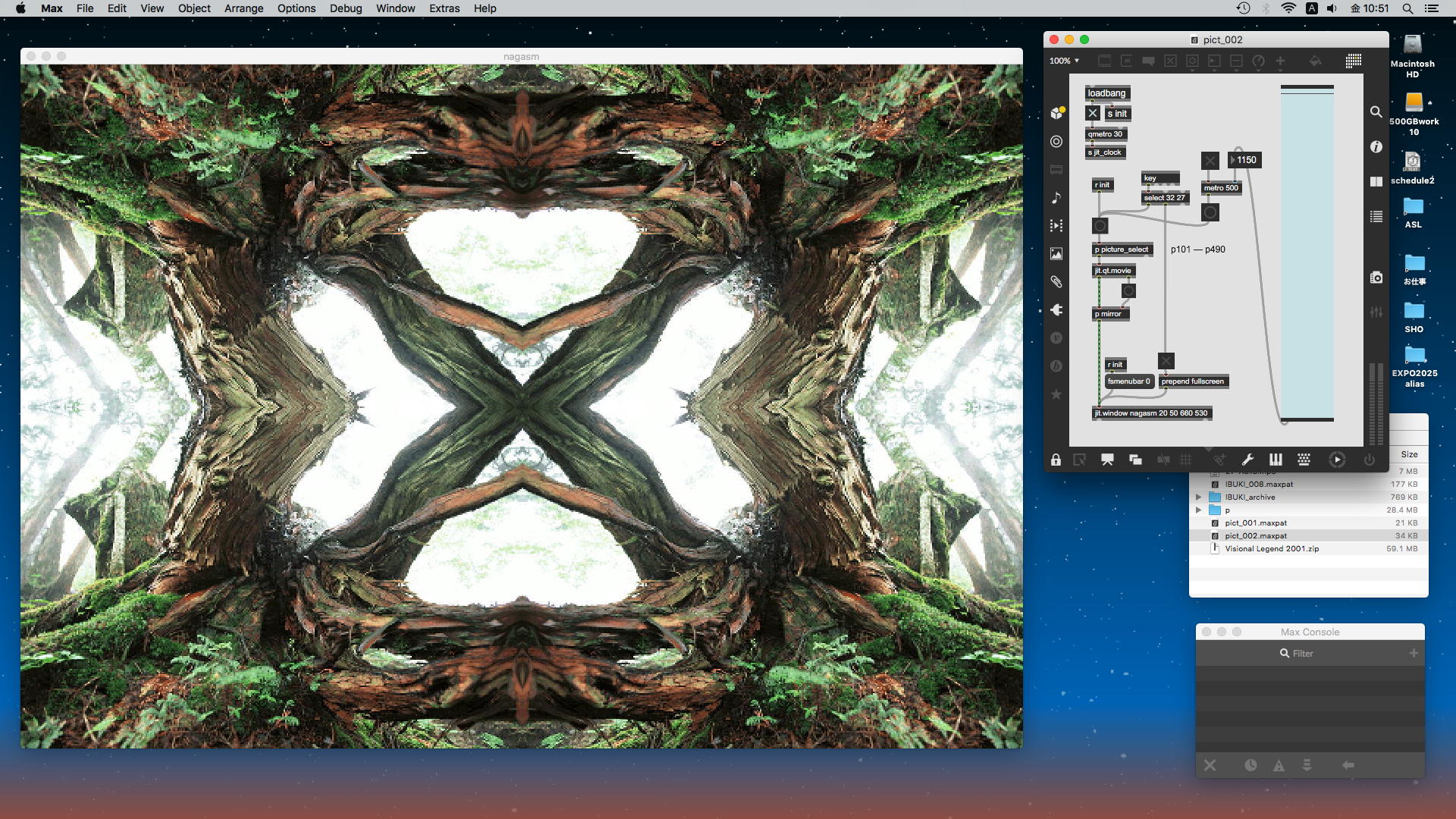

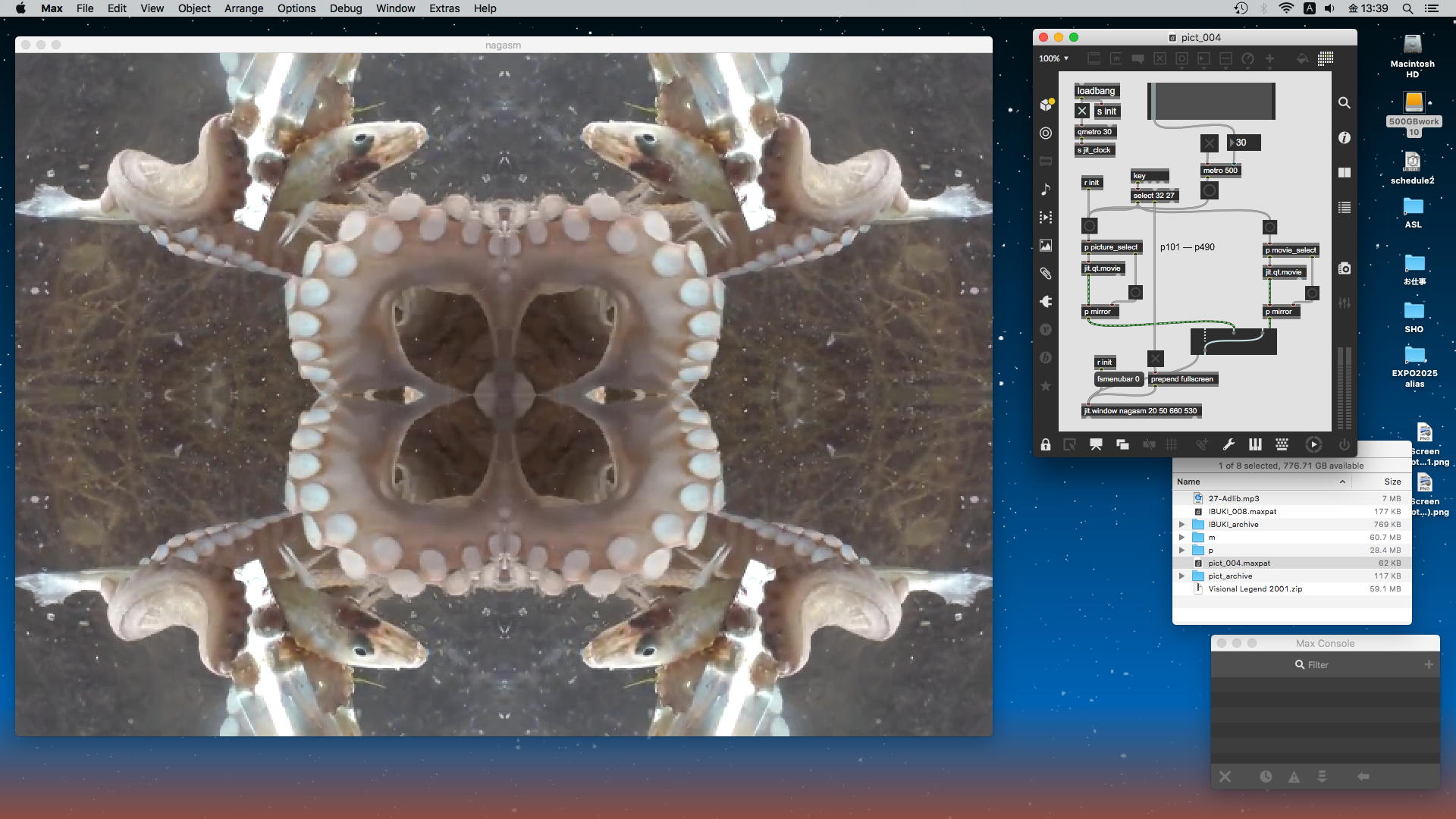

4月上旬には東野さんから「Googleドライブ経由でdinergy2のフォルダを共有させていただきました」との連絡が届いた。20年前のMaxのバージョンはだいぶ異なっており、当時のパッチの拡張子「.PAT」を叩いても現在のMaxは起動しない。従来の拡張子「.PAT」は、その後に何か世界的に有名なソフトウェア(アドビ?)で使われたので、Maxの側が拡張子を変えて「.maxpat」に逃げた経緯があった。そこでMax8の「Open File」から呼び出してみると、図6のようにちゃんとパッチが開いてくれて、さらに内部で呼ばれるサブパッチなどもエラーも出ず健在だったので、これを拡張子「.maxpat」で再保存することで、IRCAM版の"dinergy2"サウンド処理関係を2025年に完全に蘇らせた。

図6 "dinergy2"の再現実験そして4月下旬、"IBUKI demonstration"のための道具立てとも重複するのだが、楽譜に従って演奏していくサウンドパートに合わせて変容していくグラフィックパートの実験/試作が図7のように始まった。ここで問題となったのは、筆者のIntelPCのMacではAppleSiliconに比べて処理能力が低いためか、GPUを活用したGENであっても図8のように「CPU温度」が軽く90℃を超えて、Activity MonitorのCPU稼働率も250%ぐらいまで跳ね上がった[84]。このMacはIntel i5(4コア)で、全て最大にスケジューリングした場合に「400%」というのが理論的最大値なので、Max/jitter/GENのパッチ1つで「250%でCPU温度が90℃超え」というのは、ほぼ限界に近いというか、ライヴで走らせるのはかなりリスキーである。その後も何度か実験試作を作っては東野さんに連絡して相談するプロセスを重ねた[85]★[86]★。

図7 グラフィックパートの実験

図8 CPU過重負荷の様子東野さんは万博と並行して別の公演プロジェクトも抱えていて、筆者のMaxプログラミングに「待ち時間」が生じたり、ZOOMによるミーティングでようやく「ステージのイメージ図」[87]を知ったりしつつ、5月中旬には図9のような"IBUKI"で陰陽勾玉巴紋(いんようまがたまともえ)画像を回転させるアルゴリズムを完成させ、そこまでの試作バージョンとして図10のような暫定案[88]を提示して、東野さんに意見を求めた。その翌週に到達した最終版が、前述した5月25日に「こんな感じです」と東野さんに連絡した図11のバージョンである[54]。ただし実際の本番では、あまりにCPU温度が高くなるために、特に「重い処理」のいくつかについては残念ながら今回の公演での使用を断念する、という「軽量化」を施して臨んだ。結果的には全く別の原因でのトラブルによってComputerパートは全滅したのだが、Maxの「重さ」が原因ではない。

図9 陰陽勾玉巴紋を回転させる実験

図10 暫定版の途中経過

図11 制作パッチのほぼ最終版

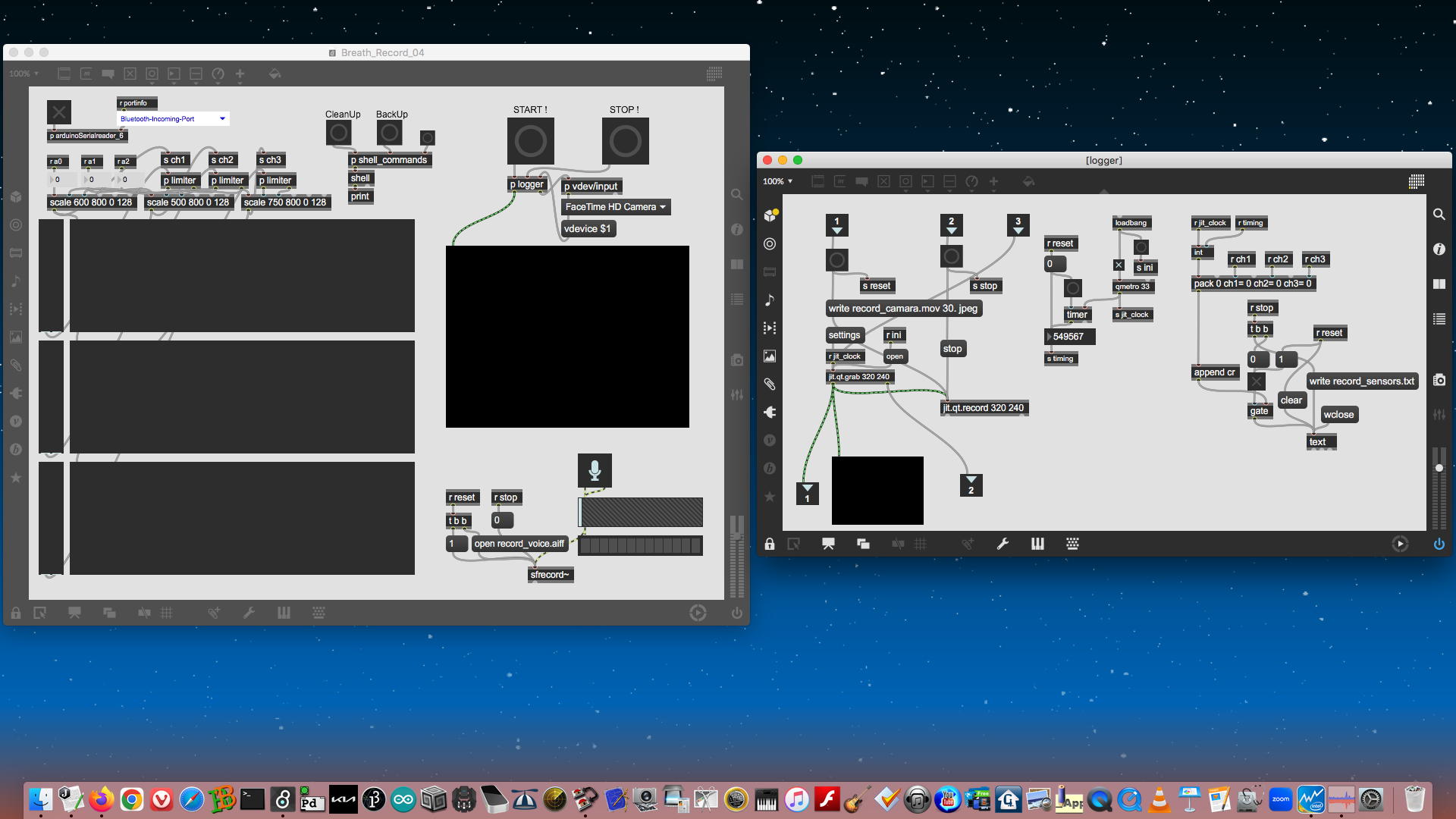

4-3. 「舞楽」呼吸・可視化のプログラミング

6月6日の、伊藤光波子さんの舞楽において「呼吸する舞楽」をビジュアライズするアプローチについては、大阪に着いてから合間にMaxプログラミングする程度である事は分かっていたので、筆者が行なったのは、持参するセンサの思い出しと確認だけだった。村尾先生の「逆腹式呼吸唱法」研究のために2016年に筆者が開発した、Arduinoを用いた「3チャンネル呼吸センサ」[46]の「記録用Maxパッチ」は図12のようなもので、対応するArduinoスケッチは以下のように超簡単なものである。void setup(){ Serial.begin(115200); } void loop(){ if (Serial.available() > 0){ if (Serial.read() == 'r') { for (int pin=0; pin<3; pin++){ int x = analogRead(pin); Serial.print(x); Serial.write(32); } Serial.println(); delay (5); } } }

図12 「呼吸データ記録用」MaxパッチこのMaxパッチでは、(1)シリアルデータを受けて表示と共にタイムスタンプを添えてtextデータとして記録、(2)カメラによる歌唱動作をmovieとして記録、(3)歌唱音声をaiffとして記録、というのを同時に実現している。これは2015年にトヨタ中央研究所から依頼された受託研究「自動運転車のための自動作曲システム」[89]の際に開発し、試作システムを搭載した特製プリウス実験車(センサやコンピュータやプロジェクタなど満載)に筆者も乗って長久手周辺の実験ドライブ(データ収集)に搭乗した。そして2018年、ポーランド・Poznanで開催されたInternational Conference on Entertainment Computing』(IFIP TC14 ICEC)において「Bio-sensing Platforms for "Wellness Entertainment" System Design」というタイトルのワークショッブ[90]を開催すると共に、筆者は研究発表「Realtime Musical Composition System for Automatic Driving Vehicles」も行った[91]。2年間の受託研究が終了してストップしたままなのだが、自動運転車というワードのためか、世界のTOYOTAというワードのためか、この発表からもう7年が経過するというのに、今でも隔月ぐらいのペースで、怪しげな国際会議?から「このタイトルで発表してくれ」とか、怪しげなジャーナルから「このタイトルで投稿してくれ」という英語の禿鷹メイルが届き続けている。

4-4. Maxプログラミングに関する補足

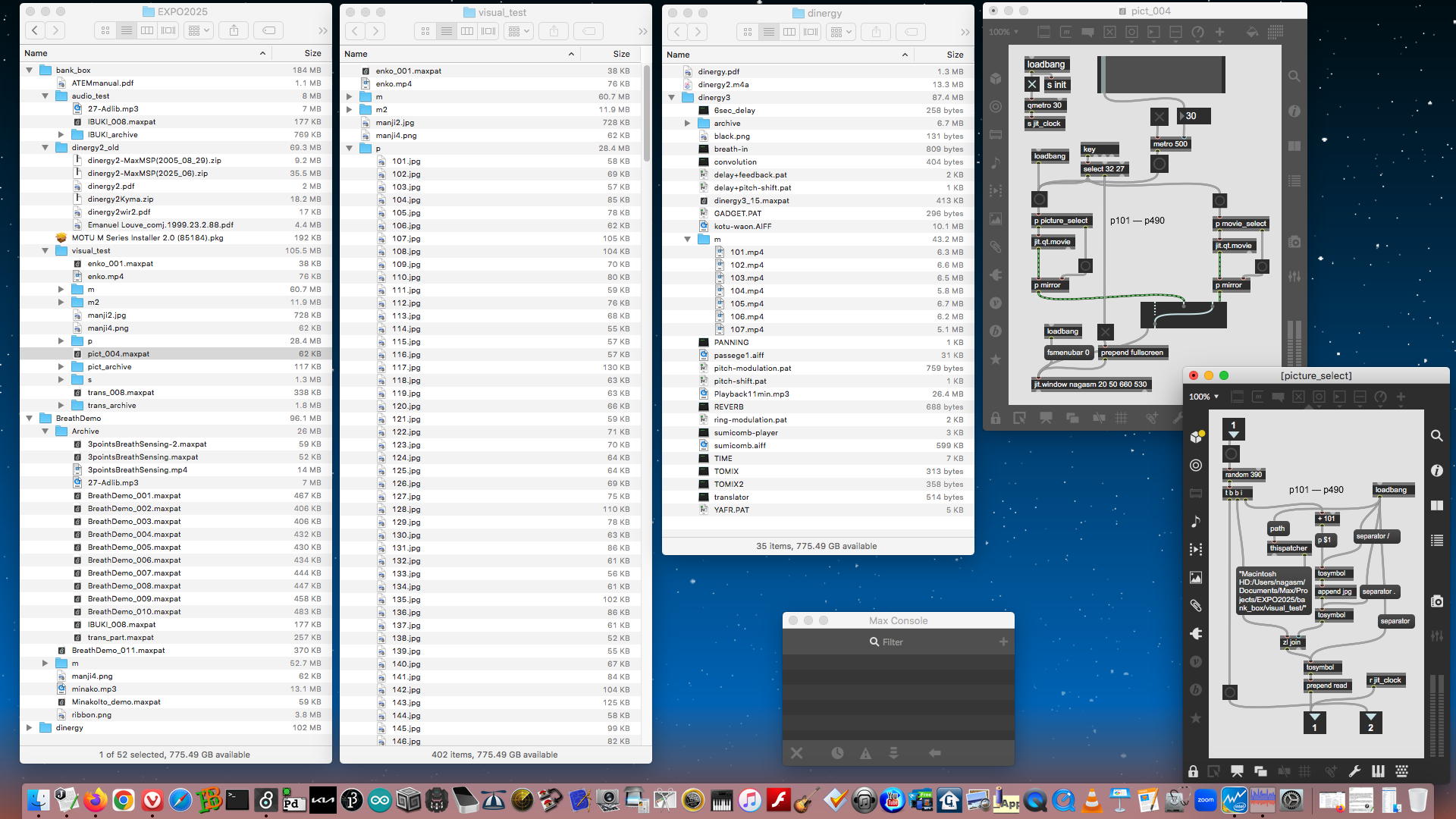

本項で紹介するのは、「多数の素材ソースから選択して」・「シームレスのループ動画として表示する」というMaxプログラミングに関する、ややテクニカルな情報(3件)である。素材(動画・静止画)が数本程度であれば、Maxパッチの置かれたディレクトリに横並びに置いて、ファイル名を明示的に指定してopen/readすればいいのだが、数百本からリアルタイムに(randomを含む)指定するとなると作戦は異なってくる。さらに今回発見したのは、数多く出回る「フリー素材」だけでなく、名門「アドビ」商品の有料素材集であっても、考慮すべき大きな課題を孕んでいたという事だった。なお、ここで報告する情報はOSX El CapitanのMac版Max(8.5.7)における状況であり、Windows版その他の異なる環境については不明である。図13は、今回のMaxプログラミングに関する"EXPO2025"ディレクトリの中身と、その中の「visual_test」ディレクトリの中にある「pict_004.maxpat」という実験中のパッチの様子である。ここではランダムに選ばれる素材静止画としてサブディレクトリ「p」内に「101.jpg」〜「490.jpg」の連番とした390本を用意していて、それを上の階層にあるMaxパッチから呼び出す手法のサンプルとなっている。Maxでは横並びでない別階層のファイル指定には「相対パス」でなく「絶対パス」が必要なので、「thispathcr」オブジェクトでパッチ自身が置かれたルートからの絶対パスを文字列として取得して、そこに下の階層のパスを付加してファイル指定する。この例ではそこに同じ桁数として101から999までの連番ファイルを指定すれば簡単になるという、ちょっとしたテクニックである。

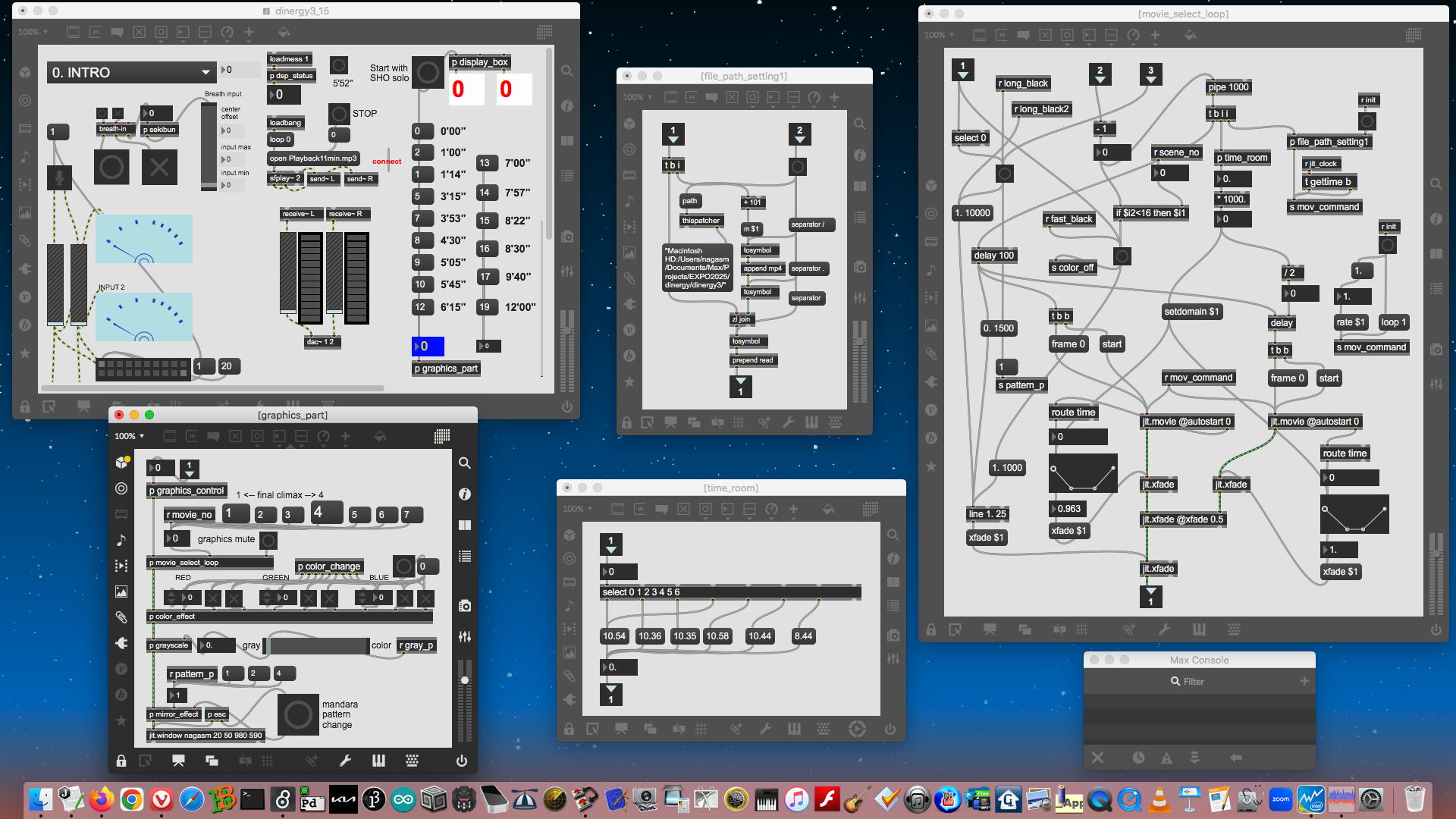

図13 "EXPO2025"ディレクトリの様子図14は、最終的に"dinergy3"の公演に使用した(結果として不発の)Maxパッチ「dinergy3_15.maxpat」と、最終的に6本となった素材動画ファイルから呼び出して「シームレスのループ動画」として再生する部分のサブパッチ群である。次に述べる「mp4ファイルへの対策」を施した6本の素材mp4ファイルごとのdurationを定数として参照した上で、横並びした2つの「jit.movie」オブジェクトで同じ素材mp4ファイルをopenするが、一方は即刻「frame=0」から再生するのに対して、もう一方は取得したdurationの1/2のディレイ後に「frame=0」から再生する。そして両方のmovieには「fade in → maxレベルで持続 → fade out」というエンベロープで変化するdepthのクロスフェードが施されており、結果として一方のmovieのフェードインから始まって、その後は交代にクロスフェードのLoop動作を続けるという構造になっている。これにより、動画編集ソフトを用いて従来行ってきた、「Loop再生すると継目が無いmovie作り」の手間が消滅した。ただしそのためには、次項の注意点が必要である。

図14 「dinergy3_15.maxpat」などそれぞれの処理について実験ソフトを作っては全体システムに統合する、というプロセスでのMaxプログラミングだったが、上述の「シームレスのループ動画」化の段階で突き当たったのは、「いろいろなmp4」という問題だった。筆者は主にマルチメディア素材(サウンド、動画)の前処理としてQuickTimePlayer7Proを活用しているが、ここで遭遇したのは、図14のようなパッチで実際にmp4ファイルによるシームレスのループ動画が実現したのに、別のmp4ファイルでは動作が異常になって、正しくループしてくれないという現象だった。これまで単に「動画ファイル」として安易に扱ってきた「mp4ファイル」というのは、実は「デジタル・マルチメディア・コンテナ」フォーマットであり、内部的には色々な動画エンコード方式や付帯情報までが包含されている[92]。そして、東野さんから受け取ったAdobe素材集の個々のmovieというのは、外見上は連番で並んでいるmp4ファイルなのだが、どうも実際には別々の作家/スタジオに委託して作ったもの等が混在しているらしく、細かい内部仕様がバラバラであるらしいと判明した。これは今後も肝に銘じておかないといけない。

筆者が今回のプロジェクトで得た対応(経験則)としては以下のようになった。東野さんから受け取った素材動画(全てAdobeから購入)は7+9=計16本だったが、ちゃんとLoop動画に出来る(jit.movieでgettimeコマンドによって現在の再生位置を返す)ものと、何故かその値が正しくない異常なもの(dinergy3では7本中3本、IBUKIデモの方では9本中3本)があった。そこで以下のような手法を編み出して、完全に解決することが出来た。参考にしていただければ幸いである。以下、正常なmp4を「動画A」、異常なmp4を「動画B」とする。

・動画AはQuickTimePlayerでもjit.moveでも再生できて、gettimeコマンドにも正しく値を返す ・動画BはQuickTimePlayerでもjit.moveでも再生できるのに、gettimeコマンドに対しては異常な値を返す ・そこで、QuickTimePlayerProで動画Aと動画Bをそれぞれopenする ・openした初期状態の動画Bで、ctrl-A、ctrl-Cとして全体を「コピー」する ・openした初期状態(ポインタは先頭)の動画Aに移り、ctrl-Vして、冒頭から動画Bの中身を「ペースト」する ・この状態で動画Aの中身は「冒頭から動画B」→「続いて動画A」という連結したムービーになっている ・ここで動画Aの範囲指定カーソルの右側を動画の最後に移動させる ・続いて範囲指定カーソルの左側を連結された後半の動画Aの冒頭よりちょっとだけ前にする ・この状態でカーソルの「範囲指定」は、「動画Bの最後のちょっと」→「続いて動画A」という範囲を指定している ・ここでctrl-X(あるいはdeleteキー)でその「指定範囲」を消す ・この状態で動画Aの中身は、冒頭からさっきの動画Bになっていて、最後だけほんのちょっと切れている ・その動画Aを、保存場所を別のところにして、「動画B」という名前を付けてexportする ・ここでQuickTimePlayerProをいったんquit→変更された動画Aを保存するか聞かれる→保存しないで捨てる(discard) ・discardなので元の動画Aは結局、何も変わらない ・exportされた動画Bを、元々の動画Bに上書き(replace)保存する ・これで、正常な容れ物に中身Bを入れた、正常な動画Bが完成する。やや短くなったdurationはインスペクタで確認しておく5. おわりに

NIME/MAF2004で共演した20年前のコラボレーション[93]からの年月を感じることもなく、Computer Musicの世界は広いようで狭いのか、色々な「縁」が互いの伏線になって結実するという実例がまた増えた。要するに一人でやっていても限界があるが、コラボレーションの精神・オープンソースの精神が重要なのではないかというのが筆者の持論である。SUACをリタイアして1年半、これまで過去に音情研などで交流があった人々、さらには筆者の文献等[94]をどこかで知った見ず知らずの学生などからのコンタクトがあり、アドバイスだったりコラボレーションだったりという新しい可能性が日々、生まれているのは嬉しい事である。本稿の報告自体が、実はある「伏線」に発展しつつあるという事実を最後に書き添えて、全てに感謝したい。生成AIについて

和文タイトルから英文タイトルを作成するためにWeb版「Google翻訳」[95]を用いた以外、本稿では全てにおいて一字一句たりとも、所謂「生成AI」の支援を用いていない事をここに明記する。