|

生体センサによる音楽表現の拡大と

1998年8月 長嶋 洋一

コンピュータ音楽のパフォーマンスに不可欠なマンマシン・インターフェースである「新楽器」について、心拍センサ、筋電位センサ、光ビームセンサ、静電タッチセンサ、笙ブレスセンサなど、主として生体センサを応用した開発例を紹介しつつ、その音楽的な可能性について検討した。まず96年から98年にかけて発表した具体的な作品への応用事例をもとに、センサについての詳解、システム内での位置づけ、リアルタイムパフォーマンスにおける課題、センサ情報に対する音楽情報処理の手法などを紹介し、次いで実際のパフォーマンス事例の経験則とあわせて、音楽表現の可能性を拡大するツールとして、また音楽演奏表現を支援するツールとしての検討を行った。

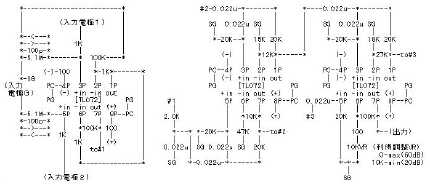

本体のサイズはVHSビデオテープ程度の大きさで非常に軽く、腰にぶら下げても負担とならない。これでいて、BioMuseやミブリのように外部に接続する大型の機器の必要なしに、筋電パルスをアナログ電圧として出力しつつ、同時にA/D変換されたMIDI信号を標準で出力する。 2-1. システム仕様このシステムは以下の要素から構成されている。(1)ノイズ除去付きOPアンプ・アナログセンシングアンプ回路、(2)生体ノイズそのものの直接出力回路、(3)A/D変換回路、(4)A/D 出力をMIDI情報として出力するための小型マイコン回路、である。この最初のバージョンでは006P電池を2個使用する。出力ケーブルはMIDIとRCAのライン信号の2本である。2-2. センシング回路フロントエンドのセンシング回路を以下に示す。基本的には差動増幅器であり、共通電位としてのアナロググラウンド端子からの入力によって、筋電位入力端子へのコモンモードノイズを相殺する。

2-3. コンタクト電極センサの筋電バンド部分には、コンピュータメモリを増設する時に人体に帯電した静電気で故障するのを防ぐために付属してくる、静電気放電用のリストバンドを改造して利用した。このリストバンドには、人体へのショックを防止するために、内部に1Mオーム程度の高抵抗が内蔵されていて、生体用電極としてはこの抵抗が邪魔になる。そこでリストバンドのモールド部分を壊して露出させ、抵抗を外して直接にコードをハンダ付けした。

BioMuseと違って、このマシンではノイズキャンセルするために、接地電極として足首にも同じバンドを付ける。たとえば両手首にバンドをつけてこの間の筋電パルスをセンシングする時には、この2本と足首の1本、合計3本のバンドを取り付ける必要がある。しかし、BioMuseでは必須だった、導電ジェルをべたべたと塗る必要もなく、ただこのバンドをはめるだけで、なかなか良好に筋電パルスをセンシングした。 2-4. パフォーマンスこのセンサは、1997年10月に初演された、"Brikish Heart Rock"という作品で使用された。この作品はフルートとセンサ奏者の二人のパフォーマのためのライブComputer Music作品である。この作品においては、MiniBioMuseのMIDI出力は使用されず、筋電位ノイズそのものにエフェクトをかけた、一種のなめらかなノイズ源として、パフォーマーの即興により演奏された。

またこのセンサは、1997年11月に初演された、「天にも昇る寒さです」(怪談楽団)という作品でも、同様の意図で楽器群の一つとして使用された。 3. 心拍センサ3-1. プロジェクトNTTの新しい美術館ICC(InterCommunication Center)が1997年10月25日から12月7日まで開催した第1回ビエンナーレで準グランプリを受賞したのが、唯一の日本人参加者・前林明次氏の作品「Audible Distance」である。これは視覚と聴覚の相互関係を見つめ直す、というコンセプトに基く体験・参加型のインスタレーションである。来場者の3人がそれぞれ、3次元CG画像のためのHMDをかけ、3次元サウンドを聞くヘッドホンをして、約5メートル四方の暗い場内をさまよい歩く。各プレーヤのHMDとヘッドホンには、他の二人のプレーヤの位置と距離に応じたCG映像とサウンドが現われ、その距離に応じて視覚と聴覚に変化が起きる。当然のことながら、プレーヤが向きを変えて視線を移動させれば、HMDとヘッドホンの視界と音響もこれに伴って移動し、自然な空間を感覚できる、というものである。また、それぞれのプレーヤは心拍センサも身につけていて、上記の映像とサウンドはこの心拍に同期して変化する。なお、この作品は現在、ICCの常設展示作品として一般に公開されている。3-2.位置検出センシング同じスペースを3人のプレーヤが勝手に移動する、という状況を非接触でセンシングする方法としては、「CCDカメラで画像認識を行う」というのが定番である。問題はそれぞれのプレーヤがきょろきょろと視線を回転させる状態をセンシングする方法で、これが不正確だとHMDの視野とのずれが不快感となって問題化する。そこで、「各プレーヤが前頭部と後頭部の2個所に赤外LEDを持って、この2点で視線の方向ベクトルを決定する」という方法を採用した。それぞれのLEDはワイヤレス制御で時分割的に点灯し、同期して画像処理される。CCDカメラは会場の上空5メートルの位置に固定した。画像処理については、パソコンの拡張ボードタイプの画像処理ボードと、オンボードで画像のエッジ検出を行う専用ボードとを併用することで、ホストパソコンの処理量をカバーする、という方法に落ち着いた。処理速度としては、心拍のオーダである毎秒2回(3人それぞれ2点の計測で合計12ポイント/秒)を目標とした。また、心拍センサ、位置センサの全ての情報はMIDI情報としてCG系とサウンド系に送ることにした。これはメディア・アートのプラットフォームとして"MAX"が定番となっているためであり、動作エミュレータ等でもMAXは活躍した。以下は、試作開発中のセンシングシステムの様子である。

3-3.心拍センシングモジュール心拍センサは色々な方式を検討した結果、耳たぶにクリップ状のセンサを挟むタイプとした。これはスポーツジムなどで使用されているもので、耳たぶの血管を流れる血流の影が心拍と同期して変化するのをセンシングするものである。

これは、心拍センサの「耳たぶクリップ」部分であり、以下は、この信号をワイヤレス送信するモジュールである。こちらも006P電池内蔵だが、心拍情報のノイズを除去するためにカードマイコンを内蔵している。

4. ハープセンサ4-1. システム仕様このセンサは「光の弦」というイメージをもとに、張り合わせた額縁に仕込んだ光ファイバセンサによって実現した。

この長方形の枠に、垂直方向に走る13本、水平方向に走る3本の光ビームを「弾く」ことで演奏する。個々の光ビームは、センサモジュールの調停機構によってまったく干渉することなく独立にセンシングされ、この情報がMIDI化されて出力される。 4-2. システム設定とパフォーマンスこのセンサは、1997年10月に初演され11月に再演された、"Atom Hard Mothers"という作品で使用された。この作品は二人のパフォーマ(オリジナル身振りセンサ、ハープセンサ)のためのマルチメディア・ライブComputer Music作品である。この作品においては、音楽の進行に従ってハープセンサは「楽器」としてのモードを刻々と変貌させる。すなわち、(1)枠内を単一の平面とするゴング、(2)枠内を6区域に分割して異なった発音をする分割ゴング、(3)垂直方向に6本の弦が張られたようなハープ、(4)垂直方向に13本の弦のハープ、(5)垂直方向13本の弦に水平方向3本の弦による音域移動を加えた「2次元ハープ」、等の動作を組み合わせた。

またこの作品は、1998年3月に相愛大学で初演された作品"Atom"でも、同様に使用された。 5. 静電タッチセンサテレミンやオンドマルトノの演奏の微妙なニュアンスを求めて、人体に誘起する静電気をセンシングしよう、という試みの歴史は長い。ただし、静電気の場合には、接触部分における個人差と、同じ個人であっても気温や湿度による変動成分がかなり問題となる。

は、1997年10月に神戸で初演された、"Brikish Heart Rock"という作品で使用された、静電タッチセンサである。またこのセンサは、1997年11月に初演された、「天にも昇る寒さです」(怪談楽団)という作品でも使用された。

このセンサ自体がオンボードのマイコンによってある体系のスケール感を持つMIDI ノート出力を行う機能を持っている。 システムとしては、市販されているタッチセンサ(電極に触れると、人体に誘起しているノイズによってON/OFFする)と同じものを5回路、搭載してMIDI出力化したものである。しかしここでは、これとともにボード上(敢えてメカニックな概観をそのまま露出させている)の並んだLEDが次々に点灯する、という一種のインスタレーション作品として制作している。この作品だけでなく、単体のインスタ作品としての展示・体験も可能である。ちなみにタッチの電極部分は、大阪・日本橋のジャンク屋で発見した、放熱フィン付の大電力抵抗器である。この放熱フィンをタッチ電極として利用している。 ところがこのセンサでは、当初の目論見であった「微妙なタッチのニュアンスの検出」には成功しなかった。センシング回路部分に飽和特性があり、どうしてもON/OFF以上の情報を安定して得られなかったからである。この部分は次期のバージョンへの課題として継続している。 6. 笙ブレスセンサ雅楽の伝統的な楽器である「笙」をインタラクティブComputer Musicに使用するために、笙の内部に小型のマイクロスイッチを仕込んでライブにKymaをコントロールする、というシンプルな一種のセンサを97年に制作した。このセンサを活用した東野珠実の作品"dinergy 2"[18] はICMC1998に入選した。これを受けて、笙の呼気と吸気の両方のバリューをリアルタイムにセンシングしてMIDI化するための「笙ブレスセンサ」の開発プロジェクトが進行中である。ここでは、大気圧センサモジュールを活用して、笙内部の「空気だまり」部分の内部圧力をセンシングする。ただし、笙という楽器は非常にユニークな構造と音響発生メカニズムを持っている。たとえば、空気だまり部分は密閉された空間になっておらず、開管であるそれぞれの竹から空気はほぼ自由に漏れ出てしまい、センシングにとって厄介である。これらの課題を克服して意味のある情報を検出できるかどうかについては、機会をみて報告していきたい。なお、このセンサの第1号機を実際の作品に利用して最初に発表する機会となるのは、1998年9月19日、神戸・ジーベックホールでのコンピュータ音楽国際フェスティバル(ICMF98)における、作品"Visional Legend" --- for SHO and live computer music with live graphics (Performance : 東野珠実)の初演の予定である。

7. センサフュージョン

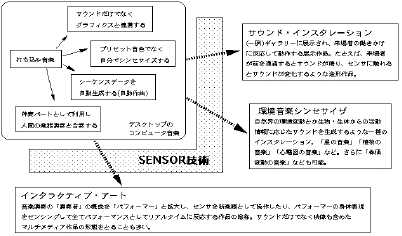

このようないろいろなセンサを一種の楽器として音楽パフォーマンスに利用するためには、いくつかの経験的なポイントの存在を確認している。まず何より、自然楽器のような「万能の楽器」を求めてはいけないようである。歴史とともに多くの音楽家と職人が作り上げてきた自然楽器(生き残っているもの)の良さは、とうてい一朝一夕に出来るものではない。そこで、とりあえずのアプローチとしては「センサフュージョン」「モジュール化」という手法が重要であると考えている。以下、一例をあげて検討する。 7-1. "Asian Egde" での例

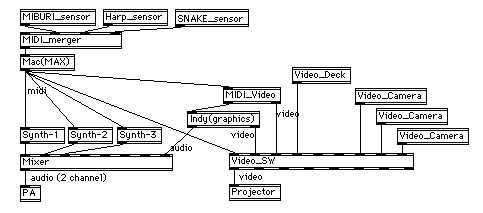

これは、1996年に初演されたマルチメディア・インタラクティブ作品"Asian Edge"のシステムブロック図である。この作品の全てのシステム構成要素は、MIDIネットワークによりリアルタイムに情報交換することで全体の構成を実現する。まず音楽系では、あらかじめ音響処理されたサウンドサンプルを、記述されたUnixシェルスクリプトに従ってMIDIトリガで一種のサンプラーのように音響生成する1台目のIndyワークステーションと、このIndyおよびMIBURI-sensorおよびSNAKEMANと名付けたセンサからのMIDIマージ情報から全体を制御する1台目のMac(MAX)が中心となる。ここからの制御情報はサンプラー、エフェクタ、MIDIビデオスイッチャおよび2台目のMacを駆動する。このMac(MAX)は画像系も担当し、シンセ、オリジナルGranular Synthesizerおよび2台目のリアルタイムCG用Indy(一部サウンド生成)をMIDI制御する。MIDIビデオスイッチャにはIndyの映像とともに、3台のビデオデッキのBGVおよび3台のビデオカメラのライブ映像等を同時に入力し、MIDI制御によって3台のプロジェクタから3面スクリーンに投射する映像を音響系と同期してリアルタイムに切り換える。

MIBURI-sensorはPerformerの両腕の手首・肘・肩の曲げをセンシングし、SNAKEMANは赤外線ビームの遮断スピードを検出する、一種の楽器である。Performerはマイクに発声するとともにこれらの楽器を用いて自分の音声サンプルをトリガして「演奏」する。全体の時間的進行は1台目のIndyがサウンドサンプルと同時にMIDI出力する時間コードに従い、センサの動作モードやCGのシーンを切り換える。

ここでの技術的ポイントは、Indyに入るMIDIトラフィックを必要最低限のものにフィルタリングするためのMIDIフィルタであり、一般的なMIDI情報をそのまま入力させればカーネルから強固にフリーズしてしまう。また、それぞれのブロックをMIDIという共通プロトコルでモジュール化していること、全体のシステム化とリアルタイム制御にMAXを活用することも重要なポイントとなった。 7-2. シーンの管理とセンサ情報このようなパフォーマンスにおいては、シーケンサをスタートさせて自動演奏させ、それに合わせてパフォーマーが演技・演奏する、というようなことは最初から発想されていない。パフォーマーの表現がセンシングされ、これをトリガとしてサウンドや映像が駆動されるのは当然のこととして、さらに積極的に、音楽のシーン展開などの進行そのものもパフォーマーに委ねている。これは、タナカアタウ・木村まり・志村哲などの先端的なComputer Musicの作曲家/演奏家の作品のパフォーマンスではより鮮明である。音楽の進行の全てをパフォーマーに、特にその即興に委ねる(極端には、気分がノッてきたら終わらずに延々と続けたり、最初に戻ってまた始めることすら可能)ことの音楽的可能性とライブにおけるリスクについては、今後も検討していきたい重要な課題である。

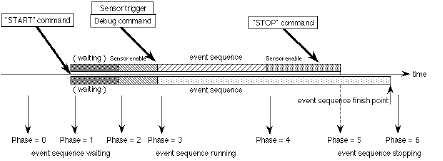

これは、このようなインタラクティブ・ライブパフォーマンスをアルゴリズム作曲する上での一つの参考モデルである。センサからの情報でシーンを進める、と言うは簡単であるが、もしそのセンシング情報がたまたま拾われずに来なかったら、音楽はストップしてしまう。あるいはチャタリングやノイズや誤差で、1発のはずのセンサからのトリガがたまたま2発きてしまったために、あるシーンが瞬時に飛び越えられてしまう、というリスクも十分に考えられる。そして、演奏に使っていないセンサからの刻々と流れる情報が他の情報を圧迫する可能性も少なくない。そのようなかなりクリチカルなセンサ情報にシーン展開を任せる、というのはかなり重大な決断なのである。 ここでは、パフォーマーに不自然さを感じさせずに、いかに安全弁を多重に入れて、さらに緊急時に危機を脱するパスを用意しておくか、というアルゴリズム作曲上の発想が必要である。しかしこの苦労は報われる。単に音を出す、という以上の可能性をパフォーマンスに与えることは、そのまま音楽の可能性と演奏表現の幅を拡大することにつながっているのである。パフォーマーは「再現」するのでなく、そこで「創造」することを求められてくるのである。 7-3. MAXが安定走行する環境について(経験則)MAXが安定に走る環境というのは、ライブパフォーマンス等では必須の条件です。

ここでの要素には、

●68Kの場合

MacOS6.0.7 + 68K + MAX2.5.2

この組み合わせは、MIDIベースでは多量のトラフィックでも安定なお奨めです。この場合、MAXではOMSを経由せず、MAX自身のMIDIポートを使うことでさらに信頼度が増します。 ●PowerPCの場合 MacOS8.0/8.1 + PPC + MAX3.5.8/3.5.9

PowerBookではPB2400cが安定です。3400は▲印。(^_^;)

●G3の場合 MacOS8.0/8.1 + G3 + MAX3.5.8/3.5.9 初期のG3ノートでは安定しないです。PB2400cにG3カードを入れるのもOK。 7-4. センサを多数使ったライブパフォーマンス等の注意点(経験則)以下、アトランダムですが、LISTや私の作品に関して、経験的にセンサを多用したパフォーマンスからのノウハウを紹介します。MIDIトラフィックは必要最低限にする。センサの分解能を敢えて下げて情報量を抑えることも重要。 多量のMIDI情報を与えた場合、システムのレスポンスが遅延するだけであればマシで、場合によっては情報を落としたりハングすることもあるので注意する。 多数のセンサのMIDI情報をマージするためのマージャは、きちんと設計されたものでないと、トラフィックによっては情報を落としたり凍ったりする。ソフトタイプは要注意。 SGI IndyのようなマシンへのMIDIはフィルタリングして、音源系への多量の情報を突っ込まない。カーネルから凍る。(^_^;) 連続量センサ(トリガタイプでなくセンサ値をA/Dするもの)は情報量が多くなる。サンプリング精度を必要最低限にするのも手。 連続量センサでは、値に変化があった時のみ出力るように設計することが重要。変化していない値をダラダラとタレ流すのは無駄。 問題となるのは多数の情報が集中するピーク時のレスポンス。一般的な音楽演奏では、時間的に均すとたいした情報量ではない。 映像機器・照明機器などの制御では、MIDI受信からの遅延を考慮して少し前倒ししたタイミングで制御情報を送るとよい。 センシングでたまたま欠けたデータを補う機構を設けるとよい。 センサからのMIDI情報を、不要なシーンではカットするスイッチ機構を、できれば上流のハードで、少なくともMAXの入力段に設けると安心できる。 ライブでセンサがトラブった時に、マニュアルで該当する情報を送れるような機構を設けておくことも重要。デバッグやリハでも使える。

外部からくるMIDIデータ、内部でのオブジェクトを通るデータのかけ算で負荷がきまる。ピーク時の負荷を考慮し、多い場合は、ユニバーサルなタイマーを作って、必要なおりに、データを見に行く処理が有効。

8. おわりに研究と実験と創作と発表とは自動車で言えば四輪であると思われる。臆せず挑戦し、多くのご批評、ご意見、ご議論をいただきたい。参考文献[1]長嶋洋一. Chaos理論とComputer Music. 京都芸術短期大学紀要[瓜生]第16号1993年. [2]長嶋洋一, 由良泰人. Multimediaパフォーマンス作品 "Muromachi". 京都芸術短期大学紀要[瓜生]第17号1995年. [3]長嶋洋一. マルチメディア作品におけるカオス理論の応用. 京都芸術短期大学紀要[瓜生]第18号1996年. [4]長嶋洋一. インタラクティブ・マルチメディア作品"Asian Edge"について. 京都芸術短期大学紀要[瓜生]第19号1997年. [5]長嶋洋一. 音群技法による音楽作品のための演奏支援システム. 情報処理学会平成2年度後期全国大会講演論文集I, 1990. [6]長嶋洋一. Musical Concept and System Design of "Chaotic Grains". 情報処理学会研究報告 Vol.93,No.32 (93-MUS-1), 1993. [8]長嶋洋一. マルチメディアComputer Music作品の実例報告. 情報処理学会研究報告 Vol.94,No.71 (94-MUS-7), 1994. [9] Nagashima, Y. Multimedia Interactive Art: System Design and Artistic Concept of Real Time Performance with Computer Graphics and Computer Music. Proceedings of Sixth International Conference on Human Computer Interaction. Elsevier, Yokohama Japan, 1995. [10] Nagashima, Y., Katayose, H., Inokuchi, S. A Compositional Environment with Interaction and Intersection between Musical Model and Graphical Model --- "Listen to the Graphics, Watch the Music" ---. Proceedings of 1995 International Computer Music Conference. International Computer Music Association, Banff Canada. [11]長嶋洋一, 由良泰人, 藤田泰成, 片寄晴弘, 井口征士. マルチメディア・インタラクティブ・アート開発支援環境と作品制作・パフォーマンスの 実例紹介. 情報処理学会研究報告 Vol.96,No.75 (96-MUS-16), 1996. [12]長嶋洋一. [広義の楽器]用ツールとしてのMIDI活用. 情報処理学会研究報告 Vol.96,No.124 (96-MUS-18),1996. [13]長嶋洋一. 京都造形芸術大学公開講座エクステンション「インタラクティブ・アートの ための技術講座」---センサとMIDIシステムによるインタラクション入門---. [14]長嶋洋一. Java & AKI-80. CQ出版, 1997 [15] 長嶋、照岡、井口. Interactive Computer Musicのための生体センサ等を 応用した「新楽器」について. 第56回情報処理学会全国大会講演論文集(2). 情報処理学会, 1998. [16] Nagashima, Y. Real-time Interactive Performance with Computer Graphics and Computer Music. Proceedings of IFAC Man-Machine Systems International Conference. Elsevier, Kyoto Japan, 1998. (採択済発表予定) [17] Nagashima, Y. BioSensorFusion : New Interfaces for Interactive Multimedia Art. Proceedings of 1998 International Computer Music Conference. International Computer Music Association, Ann Arbor USA. (採択済発表予定) [18] 東野珠実. 「dinergy 2 for Sho and Live Computer」の創作. 慶應大学大学院 政策・メディア研究科修士論文, 1998.

|