|

"Asian Edge" について 長嶋 洋一

0.はじめにComputer Music作品を作曲していく上で、常に新しいアプローチを試みた実験を 盛り込むように努めている。本稿では、1996年7月13日に神戸・ジーベックホール でのコンサート「コンピュータ音楽の現在'96」(日本コンピュータ音楽協会)で 初演された作品 "Asian Edge" について、その構想から作曲に至る過程を詳細に報告 する。Computer Musicの分野では、楽譜に音符を書き込んだりシーケンサにデータ を打ち込むスタイルだけでなく、まず必要な装置/センサ/ソフトウェア等を オリジナル開発することから始まるような作曲もある、という事例の紹介である。1.コンセプトこの作品の基幹コンセプトはタイトルの通り、広い意味でのアジアである。多様な 生物・多様な種族・多様な文化・多様な歴史のるつぼ、というモンスーン地域の、 どこからでも生命が涌いてくる混沌・雑然とした力強さ、を音響と映像とで紡ぐこと を当初から目指した。しかしこの時点では具体的な作品上演形態のイメージはほぼ ゼロであり、以下の作曲の過程で次第に明確になっていった。筆者のこれまでのComputer Music作品では、主に音響素材としては市販の電子楽器 のプリセット音色をそのまま音源として用いてきており、オリジナル製作した Granular Synthesis音源というのは例外的なものだった。これは、 ・サンプラーによる自然音の安易な利用は邪道である、という個人的な思い込み ・いわゆる音作り(シンセサイザの音色パラメータいじり)というのは際限なく 時間のかかる作業の割に、結局は楽器メーカの規定した枠組みを越えられない ・カオスのアルゴリズムなど音楽情報生成の部分に関心が高かったために、敢えて 音響生成の部分はシンプルにしていた[1][2][9] ・センサを活用したリアルタイム・マルチメディア・パフォーマンスに関心があり、 インタラクティブ的な音楽に比重を置いていた[3]-[8],[10][11]などの理由による。 しかし、1995年10月に東京で、11月に神戸で発表した作品 "Virtual Reduction" に おいて、それまで暖めていた「声」という素材を利用する機会があり、ここで 本格的に音響素材を信号処理することへの関心が高まっていたこともあり、本作品 では初めての試みとして、気合いを入れて音響素材を徹底的に練り上げることを 決意した。これはComputer Musicの作曲においては、途方もない時間をかけること を覚悟することであり、従来の作曲よりも一桁多い時間がかかることを意味した。 下図は、最終的なドキュメントとしてコンサートプログラムに織り込まれた「作品 解説」である。

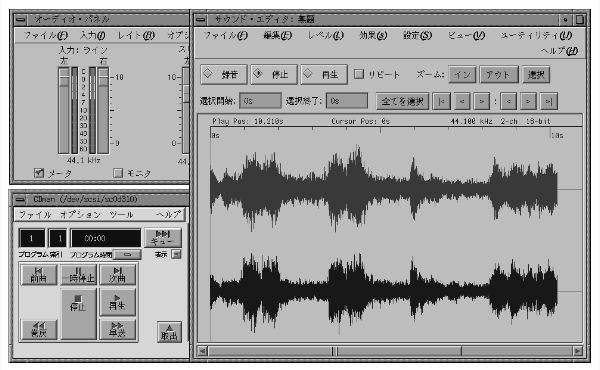

ここには、『タイトルの「Edge」には、秩序のある状態から カオス(混沌)状態に落ち込む、というその境界上の微妙な領域、という意味が重ね られている』とあるが、これは半ば後付けの定義であり、当初は「まったくアジア色 そのもの、というエスニック趣味にしたくない」という程度のものであった。 2.調査と予備実験まず調査として、音響素材となる「アジア的」「自然音」を多数、求めた。この中 には民族楽器の音響カタログCDや、映像用効果音カタログCD、そして多数の民族 音楽CDなどが含まれる。これらの音響は、それ自体が非常に個性が強く、単純に 抜き出してサンプリングしたのでは作品が音響に負けてしまうために、素材として 細かく切り出して、さらに信号処理によって加工する方針が決定した。ツールとしてはSilicon Graphics(SGI)社のIndyワークステーションの標準機能である ディジタルサンプリングを活用した。IndyはCD-ROMドライブのCDを通常のCDプレーヤ と同様に再生しながら、同時にこの出力音響を48KHzステレオでサンプリングして データファイル化することが簡単に行える。この作品のためにハードディスクを 増強して4.5GBにしたために、MO(光磁気ディスク)に退避することなくトータルで 2時間以上のディジタルサンプルの編集が容易に実現できた。

これは、Indyの画面上で CDからサンプリングツールにレコーディングしている風景である。 Indyに標準付属しているサンプルデータのプレイヤーは、IRIX5.3版では複数の サンプルを同時には再生できないように改訂されていたために、まず最初のツール として、「同時にいくつでも音響ファイルを再生するplayer」というUnix プログラムを開発した。SGI社のUnixでは、リアルタイム機能とマルチメディア 機能が非常に強力であるために、SGI社のサンプルをチューニングした簡単な C言語プログラムを制作することによって、同時に10数本のサウンドファイル(1本 が10-20MB程度のサイズ)を再生できる環境が完成した。 このplayerツールを用いて、30秒から1分ほどの長さに切り出した民族楽器の 音響サンプルのアイコンを次々にクリックして再生してみると、多数の音響が 重なった独特の厚みとうねりの魅力を再発見することができ、この音響を作品の 中核に据えることを決定した。ただし、あらかじめスタジオで全ての音響を制作 してDATテープに落としたのでは、ライブパフォーマンスとして物足りないために、 あくまで個々の音響素材がステージでトリガされるように構成することにした。 3.演奏者/作詩/映像制作の依頼作品はライブComputer Musicシステムとともに、中心に[ピアニスト・吉田幸代] によるPerformanceを置く、という構想が固まり、出演を依頼した。吉田は以前 の作品 "Strange Attractor" の演奏において、プリピアード・ピアノへの取り組み や即興性に多くの可能性を感じさせたためである。そしてピアノという非アジア的 な楽器でなく、身振りのセンサを利用した、一種のダンスによるインタラクティブ 作品としてのイメージも次第に固まった。この作品では、イメージをより直接的に象徴するような言葉(テキスト音響素材) も重要な音楽的要素になると判断し、前作 "Virtual Reduction" でも作詩を依頼 した[詩人・千歳ゆう]に対して、コンセプトの提示とともに電子メイルにて再び 作詩を委嘱した。上図の最後にある「Asian Edge Sketch」は、3カ月ほどして電子 メイルで届いたそのテキストであり、これに対しては一切の修正・変更を行わずに、 そのまま用いることとなった。 また、このところマルチメディア作品におけるコラボレーションを続けている [映像作家・由良泰人]に対して、リアルタイムCGとともにセンサによって切り 換えられるイメージ映像(BGV)の制作を依頼した。ここでも詩人と同様のコンセプト を電子メイルにて提示し、「15分ほど連続した自然界の単調な映像を3種類」という 条件で制作依頼した。さらに、前作 "David" で由良が制作したリアルタイムCGの 一部も、本作品のためにMIDI制御カスタマイズ化した上で使用する承諾を得た。 この結果、4カ月ほどして、

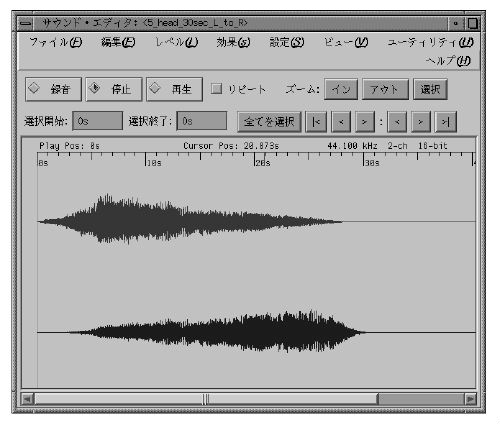

のような3本のビデオ映像が届けられたが、 「川」「木立」「滝」というそれぞれモノトーンで緩やかに動き続ける印象的な 映像であり、ここにほぼ全てのイメージ素材が出そろうこととなった。 4.音響素材と信号処理メインの音響となるアジアの民族楽器の音響素材は、第1段階として約100種類 のサウンドサンプルとして、それぞれが数十秒から1分程度の分量で切り出された。 ここからの作業は、IRIXに標準装備されているsoundeditorというツールを用いて、・頭の部分のノイズをカット ・最後の部分をフェイドアウト ・他のサウンドとの音量バランス調整(レベル) ・部分的ノイズを波形拡大ズーミングによってミュートを全てについて行う、という単純作業である。この作業は実際に耳で音響を 聞きながらマウスによる手作業で行う必要があり、かなりの時間をかけた。 次に第2段階として、次々にトリガされて再生されるサウンドサンプルに空間的な 広がりを与えるために、「全てのサウンドは全再生時間にわたって左端から右端に パンする」という指導原理を与えることにした。これにより、個々のサウンドは 常に音像を移動しつつ複雑に混じり合うこととなり、非常に有効なサウンド 空間が実現できた。このために、「指定されたサウンドファイルを左端から 右端までパンニングさせたステレオデータに変換する」というコンバータ ソフトをC言語で開発し、変換ファイルをUnixのシェルプログラムとして 与えることで、全自動で全てのファイルを自動変換した。非常に多量のファイル を正直に1バイトずつ読み込んで変換するために、作業は丸2日の自動運転と なった。パソコンで行えば連続2週間ほどかかる処理量である。

これは、パンニング 処理の完了した音響サンプルの波形の一例である。 そして第3段階として、センサや画像系などの制御とこのリアルタイム音響生成系 を結び付ける機構として、「MIDIでの音響生成システム」を開発した。ここでは、 ・IndyへのMIDI入力によって、指定されたUnixシェルプログラムが起動する ・このUnixシェル中で、個々のサウンドファイルを与えてplayer起動する ・再生終了の状況をMIDIとしてメインシステムに返すという構成をとることにした。MIDIでサウンドが鳴る、といってもサンプラーの ようなレスポンスは期待できないが、約1秒で反応する一種の巨大データの ディジタルサンプリングプレーヤとしてIndyを使用する、という構想である。 具体的に開発したUnix上のCプログラムは、既に述べたplayerと後述するcg_sound の他には、「MIDIを受けてUnixシェルを起動する」midi_process、「指定された MIDI情報を外部出力する」send_midi、という2種である。IRIXのMIDIライブラリ にはバグがあり、そのままではMIDIが正常には利用できなかったために、筆者は 原因をCライブラリソースまで辿って解析し、バグに対応したパッチを当てる ことで解決した。 以下は、これら3種のC言語ソースプログラムの一部である。

以上の準備を受けた第5段階として、

のようなUnixシェルスクリプトを「楽譜」 として記述し、何度もテストして全体の音響として「作曲」する作業に入った。 全体を3つのブロックに大別してフューチャリングする音響の種類を変えていく 中で、せっかく用意しても採用されずに捨てられた音響サンプルは全体の7割 ほどになった。最終的に作品としてコンサート会場でIndyから「演奏」された サウンドファイルの総量は、便宜的にdrawnと名付けたグループが15種145MB、 fluteグループが21種85MB、tubaグループが6種41MB、pipeグループが6種40MB、 川のせせらぎ音が4種31MB、Indyから鳴らしたPerformerの声が1種15MB(いずれも 端数切捨て)ほどである。 5.Performerの音響サンプル信号処理アジア的な音響素材とともに重要な要素となる、Performer(吉田)自身の声に よる詩の朗読も並行して行われた。まずは防音室においてDATで詩の朗読を 録音して、という予定だったが、吉田のnativeな関西弁がどうしてもイメージ と合わず、最終的には文節単位で細切れにした「単語読み上げ」の羅列データ しか録音できなかった。意図的に関東弁アクセントにするために、単語単位で しか満足のいくフレーズは獲得できない、という点は今後の課題かもしれない。これを持ち帰り、再びIndyのsoundeditorを用いて、個々の文節ごとに音量 のバランスとそれぞれの時間的間隔を微調整して、ようやく詩の1行単位にまで 再構成するためには、かなりの時間を要した。そしてこれらのフレーズは、 ・センサによってMIDIサンプラーから再生する ・ステージ上でPerformerのマイクから拾ってエフェクタをかける ・多重に重ね合わせたフレーズ群の音響をIndyから再生という3系統の素材として、再びIndy上の信号処理とサンプラーへの移管を 繰り返した。データはディジタルでなく、IndyとサンプラーとDATのアナログ ラインによるピンポン作業とした。 エフェクトについては、一般のMIDIエフェクタ、サンプラー内蔵のエフェクタ だけでなく、一部のフレーズでは、筆者の開発したGranular Samplingソフト を用いてIndy上で加工した音響サンプルを制作した。 6.センサ系の開発これまでに30種類近いオリジナルセンサを開発してきた経験から、本作品のため の新しいセンサの開発は比較的容易に実現できた。本稿ではエレクトロニクス的 な詳しい解説は省略するが、回路図や内蔵CPUのプログラムリストを含めた詳しい 解説を掲載した単行本を1997年8月に出版したので、興味のある方はそちらを 参照されたい[CQ出版「Java & AKI-80」長嶋洋一]。本作品のために開発したオリジナルセンサは2種であり、 ・曲げセンサを利用して、両腕の[手首・肘・肩]の曲げを検出する MIBURI-sensor ・太鼓から延びたパイプが向かい合う部分の赤外線ビームを遮る時間を検出 する一種の楽器のSNAKEMANと名付けたものである。いずれもカードマイコンAKI-80を使用して内部のCPU プログラムから電子回路までをオリジナル開発したものであり、独自のMIDI プロトコルでセンサ情報をメインシステムに供給する。 上図のシステムブロック図にあるように、全体の制御は2台のMacintosh PowerBook によって "MAX" を走らせることで実現した。

これは、2種のセンサおよびIndy からのMIDI情報をマージ(合流)させたセンサフュージョン情報を受けて全体を 制御する、1台目のMacで走るMAXパッチである。ここでは各種のセンサ情報を 受信してsensor_receiveというサブパッチに与えることと、指定された番号に 応じたサンプラーのサウンドをトリガする程度の処理しか実行していないが、 これはセンサからのMIDI入力情報がかなり高密度になる場合に備えた処理の 分割を行っているためである。

これは入力された各種のセンサ情報を2台目のMacにほぼスルーするだけの ブロックのように見えるが、シーンの推移とともにそれぞれのセンサ情報を カットするスイッチを制御するようになっているところがポイントである。 すなわち、不要なシーンでは不要なセンサ情報が入ってきても、この上流で カットすることで予想外の動作を避けるための安全弁として機能している。

これは2台目のMacのメインとなるMAXパッチであり、上図のシステム図から判る ように、主に画像系のコントロールを全て担当している。このパッチは単純 に「全てのセンサ情報を全てのサブパッチに」という構成となっているが、 これは前段で既に不要なセンサ情報をカットしているために行えることである。

は、このサブパッチのうちの4つを示したもので、シーン番号 ごとに必要なCG動作モードを切り換えたり、センサでGranular Synthesis音源を リアルタイム制御するためのアルゴリズムを実現している。また、ごく一部に シンセサイザK4rのサウンドを利用したが、これはほんの効果音程度の位置づけ にとどめた。 7.画像処理系の開発本作品では、上図のシステムブロック図にあるように、画像系として・3種類の背景ビデオ ・MIDIセンサで動く3次元CG ・ステージ上の3台のビデオカメラによるPerformer自身の映像 ・自作のビデオ信号発生器によるBlack信号をソースとして、オリジナル開発した「8入力8出力MIDI制御ビデオスイッチャ」 でリアルタイムに映像を切り替え、出力として3台のビデオプロジェクタによる 3面スクリーンに投射した。 ビデオスイッチャは、1995年10月に日独メディア・アート・フェスティバル に出展したメディア・インスタレーション作品「メディア・シアター[鏡の寓話]」 (中村滋延+山田実+石原亘+長嶋洋一)において使用した、MIDI制御 8入力1出力ビデオスイッチャの発展形として新規に開発した。中身は単なる ビデオマトリクスICをAKI-80で制御しているだけのものであり、フレーム メモリもないためにスイッチング時のノイズも出るが、リアルタイムの パフォーマンスにおいてはこの画像の乱れは気にならなかった。 MIDI_videoと名付けた基準ビデオ信号発生器は、これもMIDI制御で複数 種類のテストパターンやカラーを出すマシンであるが、同時にIndyに必要 最小限のMIDI信号だけを与えるためのフィルタ、という意味もあって新規に 開発した。パソコンと違って、Unixワークステーションは特にMIDI受信と いうリアルタイム処理に弱く、このような外部ハードウェアでMIDI情報の トラフィックを制限しないと、リブート復活に数分かかる、という深刻な フリーズ現象にさいなまれることになる。 8.全体の作曲とリハーサル以上のような道具だてとともに、本番前のリハーサルが重要な問題となった。 筆者は静岡県浜松市の自宅から音源関係と音響用のIndyを積んで神戸に向けて 走り、画像系のIndyは筆者が非常勤研究員を務める大阪のイメージ情報科学 研究所から神戸に向かった。しかしこれでは当日しか全ての機材が完全に揃う ことは不可能となり、リハーサルとしては非常に困難な状況である。そこで、筆者が非常勤講師を務める神戸山手女子短期大学情報教育研究センター の協力を受けた。ここでは筆者は3年前から、、ネットワーク接続された24台 のIndyを用いた、マルチメディア教育およびインターネット教育とComputer Music を教えている。この24台のIndyのうちの2台を本番の2台のIndyに見立て、 さらに3台を3面スクリーンに見立てることで、ほぼ本番と同じようなセッティング でリハーサルを行うことができ、最終のバグ出しを行えた。 さらにコンサート開催主体の日本コンピュータ音楽協会に要請して、前日 に神戸山手女子短期大学音楽科関係者に対する「公開リハーサル」と位置 づけて多めの時間帯を割り当ててもらい、ここでようやく、初めて全ての構成 要素が出そろったリハーサルを行うことができた。聴衆動員と引き換えに 協力してもらった形であるが、このリハーサルなしには本番の成功はなかった ように思われる。まさに綱渡りであった。

これは、このリハーサルの時のステージの状況である。背景映像や ビデオカメラによる実映像を背負ったPerformerのパフォーマンスの一端が 伝わるであろうか。 9.おわりにインタラクティブ・マルチメディア作品 "Asian Edge" について、その構想から 作曲/公演までの経過について報告した。この公演に関しては、記録ビデオ や録音テープはあるものの、現場に居合わせなかった人にその作品を全て感じ てもらうのは不可能である、と最初から期待していない。多量の機材と準備 から、再演の可能性も極めて低いものと思われる。しかし、当日のステージは Performerの即興によって素晴らしいものとなり、これはまさにその場限りの 作品として意義あるものだったと考えている。コンピュータという道具を用いるからには、Computer Musicとは機械のような 正確さと再現性を持つものであろう、という誤解が蔓延しているが、筆者に とってのComputer Musicとは、その場限り、一期一会、風のように流れ去って 同じものは二度とないものである、という確信をまた強くした。今後も、 一期一会のComputer Music作品を追求していきたい。 参考文献[1] 長嶋洋一 : Chaos理論とComputer Music. 京都芸術短期大学紀要[瓜生]第16号1993年, pp.28--44, 1994. [2] Y.Nagashima, H.Katayose, S.Inokuchi : PEGASUS-2: Real-Time Composing Environment with Chaotic Interaction Model. Proceedings of International Computer Music Conference, pp.378--390, 1993. [3] 長嶋洋一 : マルチメディアComputer Music作品の実例報告. 情報処理学会研究報告 Vol.94,No.71 (94-MUS-7), pp.39--44, 1994. [4] 長嶋洋一, 由良泰人 : Multimediaパフォーマンス作品 "Muromachi" 京都芸術短期大学紀要[瓜生]第17号1995年, pp.39--43, 1995. [5] 長嶋洋一, 片寄晴弘, 井口征士 : 画像情報と統合されたコンピュータ音楽創造環境の構築. 平成7年度前期全国大会講演論文集I, pp.363--364, 情報処理学会, 1995. [6] Y.Nagashima, H.Katayose, S.Inokuchi : Multimedia Interactive Art : System Design and Artistic Concept of Real-Time Performance with Computer Graphics and Computer Music. Proceedings of Sixth International Conference on Human-Computer Interaction, pp.107--112, ELSEVIER, 1995. [7] Y.Nagashima, H.Katayose, S.Inokuchi : A Compositional Environment with Interaction and Intersection between Musical Model and Graphical Model --- "Listen to the Graphics, Watch the Music" ---. Proceedings of 1995 International Computer Music Conference, pp.369-170, 1995. [8] 長嶋洋一, 由良泰人, 藤田泰成, 片寄晴弘, 井口征士 : マルチメディア生成系におけるプロセス間情報交換モデルの検討. 情報処理学会研究報告 Vol.95,No.74 (95-MUS-11), pp.63--70, 1995. [9] 長嶋洋一 : マルチメディア作品におけるカオス理論の応用. 京都芸術短期大学紀要[瓜生]第18号1996年, pp.30--40, 1996. [10] 長嶋洋一, 片寄晴弘, 由良泰人, 藤田泰成, 井口征士 : マルチメディア・アート開発支援環境における生成系エージェントのための 制御構造モデル. 情報処理学会平成8年度前期全国大会講演論文集I, pp.451--452, 1996. [11] 長嶋洋一, 由良泰人, 藤田泰成, 片寄晴弘, 井口征士 : マルチメディア・インタラクティブ・アート開発支援環境と作品制作・ パフォーマンスの実例紹介. 情報処理学会研究報告 Vol.96,No.75 (96-MUS-16), pp.39--46, 1996.

|