音楽・映像・インタラクション

2002年4月 長嶋洋一

1. はじめに

1.1 対象範囲

音楽情報処理の応用領域の一つである"Computer Music"の中で、特に「ライブ・

パフォーマンス」について、実例とともにその実現のためのシステム的な視点から

解説する。具体的には、

(1)サウンド情報とともに重要なビジュアル情報との統合と相互作用の実現

(2)センサ技術によるヒューマンインターフェースが支援する、人間と

システムとのインタラクティブ(対話的)なパフォーマンス

(3)ネットワーク経由で複数の人間が音楽セッションを行うシステム

というような内容を、「ライブ」(実時間情報処理)と「インタラクション」を

キーワードとして、過去に文献([1]-[8])に書いた事例よりも新しい状況([9]-[16])を

紹介する。

1.2 プラットフォーム、ツール、シエアウェア

ここで紹介するComputer Musicの事例やシステムにおいては、「ソフト製品」

(シェアウェア)が多数、登場する。そこで、単なる受け売りの商品広告では

ないか、と誤解されることを危惧して、あらかじめ背景として、Computer Music

の分野の「研究→製品化」という流れについて解説しておく。世界中の専門家が

汎用プラットフォームとして活用しているソフトウェア"Max/MSP"[18]の場合、

もともとフランス国立の音楽音響研究機関IRCAM[19]の研究者が開発したフリー

ウェアである。その後、実質実費配付を担当した企業が消えたため、開発者の

David Zicarelliがベンチャを起業して機能を向上させながら提供している。多数の

DSPを用いた信号処理システム"Kyma"[20]についても同様だが、これらの企業は

経営者自身が開発者・研究者でもあり、関連する国際会議ICMC[21]等の場で発表

される最新の研究成果を積極的に応用する、さらに新しいアイデアをICMCの場で

研究者として発表する、という活動姿勢に注目すべきである。自分の興味関心が

第一であり、儲け主義ではない、というのが身近に接する筆者の感想である。ここ

で紹介する多数のソフトウェアは、大部分がこのように研究成果が発展し汎用の

ツールに成熟したもの、と理解していただきたい。

2. ライブComputer Music

2.1 テープ音楽とシーケンサ音楽

歴史的には「テープ音楽」と呼ばれる、CD/MD/MP3など記録再生型のメディアや

録音放送を対象とした電子音響作品の非実時間的な制作(作曲)、というのは、現代

でもComputer Musicの重要なジャンルである。また、固定されたメディアの音響

情報の再生とは違って、演奏の際に「音源」(専用チップ、電子楽器、ソフトウェア

音源など)にMIDI形式等の音楽演奏情報をリアルタイムに転送して音響合成により

再生する、という「シーケンサ音楽」(自動演奏/DTM)のスタイルも長い歴史を持つ。

カラオケや携帯着メロ、ホームページのBGMとしてMIDファイル(標準MIDI形式)

を鳴らすのも全て同じ原理である。しかし以降、「インタラクティブ性」の

ないこれらの再生音楽(商業音楽は全てこれ)について触れることはない。

2.2 自動伴奏とセッションシステム

既に研究テーマとしては成熟した観のある「指揮システム」の場合、リアル

タイムに人間の指揮動作をセンシングして、そこから得られる情報を用いて、

DTM自動演奏のテンポ変化、音量変化、バランス、音色変化、などの音楽的

要素を制御する、というものであった。これは現在、伴奏パートの自動演奏

パラメータを人間の演奏者の演奏情報に対応して追従・変化させる、という

「知的自動伴奏」や、共奏パート情報をリアルタイムに生成する「セッション

システム」の研究に引き継がれている。これは、人間の持つ音楽的行動特性

の認知モデルや、演奏パターンのリアルタイム認識・生成を実装するために、

Computer Musicにおける挑戦的な研究テーマの一つである。

2.3 リアルタイム音響信号処理

コンピュータの性能向上は、かつて音源専用LSIとしてハードウェアで実現

していたディジタル音響信号処理をも、ソフトウェアの領域に引き込んだ。

Macintoshでは"Max/MSP"[18]や"SuperCollider"[22]、Windowsでは

"PureData"[23]、Linuxでは"jMax"[24]などのソフトウェアは、楽器メーカ

が独自のノウハウで設計製造していた音源チップ内の音響信号生成処理を、

オープンなソフトウェアにより実現する汎用プラットフォームとなっている。

また、多系列多重多量の音響信号処理のために、DSPチップ搭載ボードを

多数組み合わせ、GUIで設計した実時間処理(生成、エフェクト)のアルゴリズム

を自動コンパイルしたDSPマイクロプログラムをホストPCから転送する、という

システム"Kyma"[20]もある。パソコンの処理能力がいくら向上したといって

も性能に限界はあり、筆者の場合には"Kyma"・"SuperCollider"・"Max/MSP"

を、作品ごとにシステムの構成要素として組み合わせて使い分けている。

2.4 実例紹介(1) : "tegoto"

ここで実例として、2001年8月に日本で初演し、9月にはドイツ2都市で公演

した、筆者の作品"tegoto"[14]について紹介する。この作品は、邦楽の伝統

楽器「箏」を独奏楽器として、邦楽の「手事物」(てごともの)という音楽形式を

Computer Musicの視点から作曲したものである。事前に用意される音響素材

は皆無で、全てのサウンドは、ステージ上の17弦箏/13弦箏の生演奏と、"Kyma"

によってその音響をライブサンプリングしつつ実時間音響信号処理により変容

させたサウンド群、さらに"Max/MSP"のリアルタイム作曲(アルゴリズム作曲)に

よりこの音響を「替手」(手事物では、独奏者「本手」のフレーズを即興的に

変形させてセッションする演奏パートナー)としてライブ再構成して絡む、と

いうシステムにより音楽が進行した。古典的な形式で演奏者に渡した楽譜は

あくまで参考であり、演奏者は即興性と感性を重視した演奏を要請された。

2.5 リアルタイム作曲と即興性

このように「ライブ」にこだわるのは、音楽の要素として即興性、あるいは

「その場限り」という要素が重要だからである。クラシック音楽演奏家の

楽譜の記載からの芸術的逸脱、ジャズミュージシャンのアドリブセッション、

人間の働きかけに対応したインタラクティブ性などの、音楽の生き生きと

したリアルタイム要素は、固定的な録音やデータの「再生」では得られない

ものである。ここに、コンピュータ技術を音楽に活用する重要な意義がある。

課題としては、いろいろな階層での遅延、多種の入出力情報の関連性の記述

(アルゴリズム作曲)のユーザー支援、音楽知識や音楽認知のモデル化、効果的

なセンサ(ヒューマンインターフェース)群の実現、新しい手法/モデリングに

よるリアルタイム音響合成手法、などがあり、情報処理学会音楽情報科学

研究会[25]やICMA(International Computer Music Association)[21]など

における研究テーマの一つの柱となっている。

3. サウンドとグラフィクスのリアルタイム制御

3.1 音楽とグラフィクスとの関係

音楽は、別に聴覚だけを対象としたものではない。コンサート会場やライブハウスの

公演を思い浮かべれば明らかなように、音楽とは視覚情報とともに成立する、典型的

なマルチメディア・アートである。しかしここでのマルチメディア要素としては、

「ムービーの映像トラック/サウンドトラック」とか「プロモーションビデオ/DVD」の

ように、固定して同時に再生されるサウンドとグラフィクス、という関係は除外する。

これはシーケンサと同じで、インタラクティブな要素(ここで言うライブ性)がないから

である。一方、音楽知覚認知学会[26]などの場では、多くの音楽心理学/認知心理学

研究者により、聴覚的要素と視覚的要素の「関係性」が人間の知覚・認知・情動に

いろいろな効果や錯覚や影響を与える、という研究が地道に続けられている。一部の

メディアアートの中には、積極的にこの関係性をコントロールして人間の感性に訴え

かけよう、というようなアプローチも見られる。

3.2 音楽と連係したグラフィクス

コンピュータ音楽の演奏において、インタラクティブに、つまりPerformerの動作を

センシングして、そのモーション情報から「所定の関係性」(これをプログラミングする

作業がComputer Musicにおける「作曲」の重要な段階)を反映させ、グラフィクスを

ライブ変化させたい、というのがシンプルなスタートラインである。これは、既に完成

しているムービーをスクリーンに投射してダンサーがそれに合わせてパフォーマンスする

とか、固定的なDTMデータを再生しているカラオケに合わせて歌う(あるいはテレビでは

口パク)、という演奏とは本質的に別次元である。筆者の経験においても、まだ利用

できるツールが存在していなかった約10年前には、C言語で実時間カオス生成の

アルゴリズムによりサウンド生成するソフトや、2次元カオス描画のCGソフトを

自作[27]して、MIDI情報をカオスのパラメータにマッピングしてプロジェクション

した事や、Open-GL環境で3次元CGソフトを自作[28]して、Performerの身体

動作センシング情報によりライブ制御した事もあった[17]。

3.3 音楽と連係した静止画アニメーション

前述のようにComputer Music分野のいろいろな研究成果が具体的なシェアウェア

等として提供されるようになり、研究者であるとともにComputer Music作曲家と

して活動する筆者にとって、プラットフォームやツールとして、システムの構成要素

としてこれらのソフトウェアを活用するようになったのは自然の流れである。

これは、遠い昔には研究テーマだった「光学的楽譜認識」が現在では商品ソフトの

普及により学会から消えたこと、数年前のArs Electronica(世界的なメディアアート

のコンペ)で入選したCGエフェクトが、現在では市販のPhotoshopのメニューの1項目

として小学生でも活用できること、などと同様の、IT進展の自然な活用例である。

グラフィクスを音楽とともにライブ制御する、という目的においても、音楽生成系

システム(Performerからの演奏情報はこの上流として反映されている)からのMIDI

制御情報を受け取って、"Max/MSP"や"Director"[29]"やImage/ine"[30]や

Videodelic[31]などのグラフィクス処理ソフトウェアのMIDI制御機能によって、

多数の静止画データを一種のスライドショーとして制御する、という手法が登場し、

抽象的なCG画像よりも作品に関するartisticな意義により活用された。

3.4 ライブビデオ信号とムービーの制御

静止画を音楽パフォーマンスからの情報によって切り替えたり、多数の静止画で

アニメーション化することだけでなく、ライブビデオカメラの動画、あるいは

Quicktime等のムービーという「動く画像要素」も利用される。この場合、

長時間にわたる固定的な動画は単なるムービー再生になってしまうが、短時間の

ビデオクリップや生カメラ映像を静止画の延長の「視覚的要素断片」と考えて、

これをライブPerformanceによりダイナミックにスイッチングしたり、音楽演奏の

情報(音色、音量、身体動作など)によってズーミング/スピード変化/反転などを

行う、という手法もある。上述のソフトウェア群で実現できるものもあり、さらに

このような映像処理マシン(専用機)が電子楽器メーカからも登場してきた[32]。

クラブ系の音楽シーンでは、DV(ディスク・ジョッキー)に代わってVJ(ビデオ・

ジョッキー)が活躍し、パフォーマンスとして聴覚的要素と視覚的要素とを自在に

操っている。その一部はこれらのMacintoshソフトウェアをライブの場で膝の上で

駆使する、いわゆる「PowerBook奏者」である。

3.5 実例紹介(2) : "Wandering Highlander"

ここで実例として、2000年9月に初演した筆者の作品"Wandering Highlander"

について紹介する[33]。この作品のPerformerはダンサーであり、楽器を用いる

のでなく身体動作表現により、サウンド系とグラフィクス系をライブ制御した。

Performerの両手首・両肘・両肩の曲げ情報は筆者の開発したセンサにより

MIDI化され、全体の関係性を構築(作曲)する"Max/MSP"の入力情報となった。

サウンド系はDTM的な要素を持たず、全てのサウンド情報が乱数とPerformer

からの即興演奏情報によりアルゴリズミックにライブ生成された。グラフィクス系

は9人の共同制作者が「連画」の手法で連作した45枚のCG静止画と3台のCCD

カメラからのライブ画像を素材として、"Image/ine"およびオリジナル製作の

MIDIビデオスイッチャによってライブスイッチング/ズーミング等を行った。

システムはFig.1のような構成である。1台のコンピュータで全てを行うという

のは、ライブ公演のリスク回避、部分的制作修正リハーサル対応、という視点から

絶対に取らない指針であり、筆者の場合には多数のコンピュータの分散協調システム

を常に基本としている。

3.6 実例紹介(3) : "Visional Legend"

もう一つの実例として、2001年9月にフランスとドイツの演奏旅行で公演した、

筆者の作品"Visional Legend"[13]について紹介する(公演の模様は[34])。この

作品は、雅楽の伝統楽器「笙」の可能性を拡大するために作曲したものであり、

笙の演奏における呼気と吸気の強さを検出するオリジナルセンサを作品の一部と

して制作した。サウンドパートとしては、あらかじめ録音した笙のサウンドと

詩を朗読するバリトン音声を素材としてスタジオで制作した背景音響パートCDと

ともに、ライブ演奏される笙のサウンドをリアルタイム音響処理エンジン"Kyma"

によって信号処理している。グラフィクスパートとしては、共同制作者の作成

した64枚のCG静止画といくつかのムービーを素材として、笙ブレスセンサから

のライブ情報によって切り替えたり、ビジュアルエフェクトのパラメータを

リアルタイムに変更するために"Image/ine"を使用した。全体の関係性は同じく

"Max/MSP"上に構築(作曲)し、システムはFig.2のような構成であった。

4. ヒューマンインターフェースとインタラクティブ性

4.1 センサとヒューマンインターフェース

前述のように、インタラクティブなComputer Musicというのは、システムの

一部としてセンサが重要な要素となる。筆者はこの領域で多くのオリジナルセンサ

を作曲の一部として制作してきたが([2][5][17])、この話題は多くの専門家にとって

も関心があるらしく、国内でも[35][36]、海外でも[37][38]、このテーマでの

チュートリアルやワークショップの開催を依頼されることがとても多くなった。

音楽への応用だけでなく、センサ技術は医療・福祉分野などにも深く関係している。

なお、古典的な演奏会場での「演奏者と聴衆」という図式だけではなく、対峙した

来場者の働きかけに反応するサウンド・インスタレーション作品などにもセンサは

活用されているが、この解説は省略する[17][46]。

4.2 センサ利用のコツ

筆者はもっぱら秋葉原のカードマイコン[39]を愛用しているが、最近では汎用の

MIDIセンサも海外の何箇所からか提供されている([19][40][41])。筆者は自作の

ソフトウェアだけでなく、作曲の一部として開発したオリジナルMIDIセンサの回路図

からソースプログラムまでを全てWebで無償公開し[17]、興味ある人は実際に制作

して活用しているようである。願わくば、国内のメーカからの提供も期待される。

リアルタイム制御システムという視点から、これまで多数のセンサを活用してきた

筆者の経験則を列記してみると、(1)一つのオールマイティなセンサは期待しない、

(2)多数の単純なセンサからの情報を統合(センサフュージョン)して必要な情報を

抽出する方が有効で、(3)過剰に高精度・高速化してもシステムの処理を圧迫

したりレスポンスを悪化させるだけ、(4)Performerごと/現場ごとにパラメータ

をその場でトリミング/チューニングできる環境構築が重要、(5)センサ情報が

事故で途絶えた場合に対応した「安全弁」の必要性、などである。最後の項目

は、公演がスタートしたら止められないライブ音楽においては非常に重要であり、

リハーサルの段階でPerformerから得られたセンシング情報をサンプリング記録

しておき、万一の(断線や電池の接触不良等でセンサ情報が来ない)場合には、この

記録データを臨時に再生してほぼ同等の制御情報を生成する非常用経路、などと

いうのはインタラクティブアート作品公演における定番テクニックである。

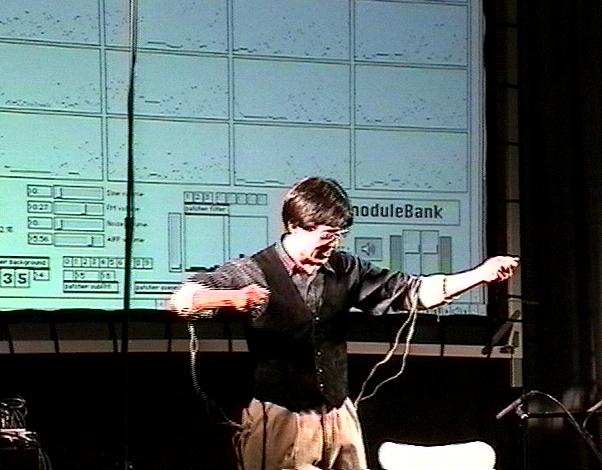

4.3 実例紹介(4) : "BioCosmicStorm-II"

ここで実例として、2001年9月にフランスとドイツの演奏旅行で公演した、筆者の

作品""BioCosmicStorm-II"[34]を紹介する。筆者は、生体情報検出制御や未確認

領域科学に興味を持つプロジェクト「VPP」[42]のメンバーとして、多くの生体

生理情報センシングを研究してきたが、この作品では、新しく開発した筋電位

センサ"MiniBioMuse-III"[43][44]を活用して自分でPerformanceを行った。

これは、片腕あたり8チャンネル、計16チャンネルの筋電位センサからのライブ

情報を"Max/MSP"で受けて、あらかじめ"Kyma"等で制作した複数のサウンド

ファイルの起動制御を含む全てのリアルタイム音響生成(ノイズ+フィルタ、16

系統サイン合成、12パラメータFM合成)システムをその場の即興で駆動する、と

いう作品である。ステージ後方には、作品そのものの"Max/MSP"パッチの実時間

動作の模様をプロジェクションしたが、この画面内の16個のウインドウに16系統

のライブ筋電位情報がグラフ表示されたために、パフォーマンスの身体動作と、

それぞれの筋電位情報の様子と、そこから実時間生成されるサウンドとの関係性が

直接的に理解できる、と特にHamburgの聴衆に好評であった。Fig.3はその公演

風景である。

4.4 生体電気刺激フィードバック

Computer Musicパフォーマンスにおいて、システムと人間(Performer)との

インタラクティブな相互作用という視点から、2002年には新プロジェクトとして、

筋電位センシングとは逆方向のアプローチも行った[16]。紙面の都合で詳細は

Web資料[45]に譲るが、低周波治療器に似た電気刺激パルスをMIDI制御によって

生成する8チャンネルのオリジナルマシンを開発し、既に3人の作曲家がそれぞれ

の作品で適用して、その可能性を議論しているところである。これは単に

新しい種類のディスプレイ(狭義には視覚的=ディスプレイであるが、マルチ

モーダルの視点からはサウンド聴取というのは聴覚的ディスプレイであり、

味覚・嗅覚と並んで、皮膚刺激も広義にはシステムからのディスプレイ出力の

一種である)というだけでなく、「聴覚障害者が(皮膚刺激で)サウンドを聞く」

という福祉分野での可能性も提起・検討しているところである。

5. ネットワーク・セッション

5.1 RMCP以前

複数の人間が、あるいはコンピュータと人間が音楽セッションを行う、というのは

インタラクションとしては自然なことであり、1985年頃から現在まで、MIDIという

標準規格が生存し続けている。これは、コンサート会場のステージ程度の距離の

範囲で、音楽演奏情報の同時性(リアルタイム情報転送)を「ほぼ」実現している

からであり、大規模な演奏会場では、サウンドの空気中の伝播速度の制限の方が

効いてきてしまう。10万人のコンサート会場では、巨大な1箇所のPAサウンドでは

音波の遅延でビートがぐしゃぐしゃになるために、多数配置した小音量PAに分配

駆動して同時に鳴らすことで解決しているのである。そして、インターネットが

登場すると、サウンドのストリーミングだけでなく、このMIDI音楽演奏情報を

データパケットに乗せて転送して「ネットワーク・セッション」する、という実験

がいくつも行われたが、某社は公開デモのデスクの裏側にシーケンサを隠すなど、

あまり目立った成功例はなかった。

5.2 RMCP登場

インターネットは本質的にベストエフォートの情報ネットワークであり、信頼性も

情報伝達速度も保証されていない。そこで後藤真孝氏(産業技術総合研究所/当時は

早稲田大学)は、本来の研究テーマである「ビートトラッキング」の研究に附随して

RMCP(Remote Music Control Protocol)という総合的な体系を独自に構築し発表

した([47]-[49])。これは、Uinx上でクライアント・サーバ方式で多数の参加者が

時間的な同期を確保した上でMIDI情報をやりとりするシステムであり、後藤氏自身

が東京とアニューヨークのライブMIDIセッションを実演紹介した。RMCPは世界に

向けて完全なパッケージとして公表されたため、筆者はこれをプラットフォームと

して活用し、多数の音楽科学生がネットワーク上で情報共有して即興セッションを

体験するシステム"Improvisession"をSGI-IRIX上に開発した[28][50]。共同研究者

の中村文隆氏はこれを発展させたシステム"Democratyrant"をWindowsNT版の

RMCPの上に開発した[51]。

5.3 RemoteGIGからOpen RemoteGIGへ

インフラとしてのRMCPによって、ネットワークセッションとMIDIベースの音楽

システムが容易に実現できる環境が整った。しかし、ここに地球規模の衛星放送

網とかインターネットのストリーミング網が普及してみると、音楽演奏の「同時性」

に対して、原理的な問題が立ちはだかってきた。いくら太い情報ネットワークや

電波であっても、「光速の限界」により、地球の裏側に届くには100ミリ秒オーダ

の遅延が生じる。これは単一方向の音楽再生伝送であれば問題ない(それだけ先に

送って溜めておけばよい)が、双方向インタラクティブに演奏情報を交換する音楽

セッションにおいては、音楽をまったく成立させないレベルの遅延となる。そこで

後藤氏はRemoteGIG、さらにOpen RemoteGIGというシステムをRMCP上に構築

して、「遅延を前提とした新しい音楽」モデルを提唱した[52][53]。これは、遅延

によって音楽セッションの同時性は無理、という前提で、12小節のブルース形式の

1ループのような繰り返し構造を単位として、「相手の1単位前の演奏と自分の演奏

とでの合奏」というセッションを相互に行う、という新しい音楽概念である。自分の

演奏情報は相手に遅延して届いて、相手はその「影」と同時セッションして、その

演奏をまた「影」として返してくるのである。RMCPはUnix上のNTP(network time

protocol)を利用したRMCPtss(time synchoronized server)によってそれぞれの

「時計」を同期させているので、最大遅延時間よりも十分に長い「単位」を用いる

ことにより、1単位遅れの音楽セッションがそれぞれの演奏者において必ず成立する。

5.4 実例紹介(5) : GDS Musicと"Improvisession-II"

不可避的な遅延があり古典的な同時性のもとでの音楽セッションが成立しない、

というインターネット時代には、RemoteGIGのように音楽そのものの概念を

変える必要がある、というのは筆者も後藤氏との議論で確認・確信した。そして

RMCPという比較的重い環境でなく、パソコン1台を単位としてもっと手軽に

即興を重視したネットワークセッションを実現する、という新しいシステムを

開発した[15][54]。「常に相手の影と演奏する」という基本概念は同等である

が、ここではRMCPで提供した「遅れを考慮した同時性」を捨てて、それぞれの

Player(ここでは演奏者というよりもセッションという一種のゲームの参加者と

しての意味もある)の時間については、インターネット遅延時間の大きさとか

音楽演奏のループ長とかをいっさい考慮・調整しない、という概念(Fig.4)の

新しい音楽モデル GDS(global deyaled session) Music を提唱した。これは、

RMCPをベースとしたOpen RemoteGIGとの違いとしては、(1)各プレーヤの

(遅れを考慮した)時間的同期については何も考慮しない、(2)他プレーヤから

届いた情報をいったん溜めて自分のループに同期させて再生合奏する、(3)自分の

フレーズは自分のループの最後にまとめて送出する、(4)伴奏部分についての

MIDI情報は転送しないで各プレーヤがサーバから入手したパラメータを元に

アルゴリズミックに生成する、(5)プレイヤーは芋づる式に他プレイヤーをリンク

してもよい、等が特徴である。筆者はこのアイデアを実際に"Max/MSP"上に

実装したシステム"Improvisession-II"を開発し、Webでも公開している。

ここではCNMAT[55]の研究成果として公開されているOpenSoundControl[56]

というパッケージによって、簡単にネットワーク上での情報交換を実現できた。

6. おわりに

「音楽・映像・インタラクション」という漠然としたタイトルのもとで、現在進行形で

音楽情報処理に関するいろいろなアプローチが続いている状況の片鱗を紹介してきた。

研究の結果はソフトウェアやシステム、公演・パフォーマンスなどの形で実験され、

モノになった場合には公開されたり製品や定番テクニックとして一般的になり、それ

自身は研究テーマとしては消えていく(モノにならなかった場合には人知れず消えていく)。

これがまた新しいアプローチの土台となり、ITの進展とともに新しい音楽そのものが提案

されていくのである。先人の研究に敬意を表しつつ活用し、実験や研究成果を積極的に

公開して共有し、忌憚ない議論を戦わせ、共同研究やコラボレーション(共同制作)により

一人ではできない新しいアプローチの実現にチャレンジしている。この世界に興味ある

方々の新たなる参加を期待している。

参考文献

[1] 長嶋洋一 : 楽音合成アルゴリズム ; コンピュータと音楽の世界, 共立出版, pp.55-68, (1998)

[2] 長嶋洋一 : 身体情報と生理情報 ; コンピュータと音楽の世界, 共立出版, pp.342-356, (1998)

[3] 長嶋洋一 : アルゴリズム作曲 ; コンピュータと音楽の世界, 共立出版, pp.402-418, (1998)

[4] 長嶋洋一 : あるコンピュータ音楽との関わり方 ; コンピュータと音楽の世界, 共立出版, pp.443-448, (1998)

[5] 長嶋洋一 : コンピュータサウンドの世界, CQ出版, pp.1-180, (1998)

[6] 長嶋洋一 : センサを利用したメディア・アートとインスタレーションの創作 ; 京都芸術短期大学紀要第20号, 京都芸術短期大学, pp.71-76, (1998)

[7] Yoichi Nagashima : Real-Time Interactive Performance with Computer Graphics and Computer Music ; Proceedings of the 7th IFAC/IFIP/IFORS/IEA Symposium on Analysis, Design, and Evaluation of Man-Machina Systems, IFAC, pp.83-88, (1998)

[8] Yoichi Nagashima : BioSensorFusion:New Interfaces for Interactive Multimedia Art ; Proceedings of 1998 International Computer Music Conference, ICMA, pp.83-88, (1998)

[9] 長嶋洋一 : インタラクティブ・アートにおけるアルゴリズム作曲と即興について ; 神戸山手女子短期大学紀要第41号, 神戸山手女子短期大学, pp.93-109, (1999)

[10] Yoichi Nagashima : "It's SHO time" --- An Interactive Environment for SHO(Sheng) Performance ; Proceedings of 1999 International Computer Music Conference, ICMA, pp.32-35, (1999)

[11] 長嶋洋一 : クラシック音楽とコンピュータ音楽 ; 神戸山手女子短期大学紀要第42号, 神戸山手女子短期大学, pp.27-45, (2000)

[12] 長嶋洋一 : インタラクティブ・メディアアートのためのヒューマンインターフェース技術造形 ; 静岡文化芸術大学紀要第1号, 静岡文化芸術大学, pp.107-121, (2001)

[13] Yoichi Nagashima : Composition of "Visional Legend" ; Proceedings of International Workshop on "Human Supervision and Control in Engineering and Music", IFAC, pp.47-65, (2001)

[14] 長嶋洋一 : SUACにおけるメディアアート活動の報告(2000-2001) ; 静岡文化芸術大学紀要第2号, 静岡文化芸術大学, pp.137-150, (2001)

[15] Yoichi Nagashima : "IMPROVISESSION-II" : A Perfprming/Composing System for Improvisational Sessions with Networks ; Proceedings of International Workshop on Entertainment Computing, IFIP/IPSJ, pp.237-244, (2002)

[16] 長嶋洋一, 赤松正行, 照岡正樹 : 電気刺激フィードバック装置の開発と音楽パフォーマンスへの応用 ; 情報処理学会研究報告 Vol.2002,No.40, 情報処理学会, pp.27-32, (2002)

[17] http://nagasm.org/

[18] http://www.cycling74.com/

[19] http://www.ircam.fr/

[20] http://www.symbolicsound.com/

[21] http://www.computermusic.org/

[22] http://www.audiosynth.com/

[23] http://www.pure-data.org/

[24] http://www.ircam.fr/equipes/temps-reel/jmax/en/index.php3

[25] http://www.etl.go.jp/~sigmus/

[26] http://wwwsoc.nii.ac.jp/jsmpc/

[27] http://nagasm.org/ASL/program/

[28] http://nagasm.org/ASL/indy/

[29] http://www.macromedia.com/

[30] http://www.steim.nl/

[31] http://www.uisoftware.com/

[32] http://www.roland.co.jp/products/dtm/DV-7.html

[33] http://nagasm.org/ASL/wander/

[34] http://nagasm.org/1106/europe/EUreport.html

[35] http://nagasm.org/ASL/original/

[36] http://nagasm.org/SSS/

[37] http://nagasm.org/ASL/berlin/

[38] http://nagasm.org/ASL/paris/

[39] http://www.akizuki.ne.jp/ashop/h8.htm

[40] http://www.infusionsystems.com/

[41] http://www.steim.nl/sensor.html

[42] http://nagasm.org/vpp/

[43] http://nagasm.org/ASL/mbm-3/

[44] http://nagasm.org/ASL/SIGMUS0108/

[45] http://nagasm.org/ASL/SIGMUS0205/

[46] http://nagasm.org/1106/SS2001/MAF2001.html

[47] 後藤真孝, 他 : MIDI制御のための分散協調システム - 遠隔地間の合奏を目指して ; 情報処理学会研究報告 Vol.93,No.109, 情報処理学会, pp.1-8, (1993)

[48] Masataka Goto, et al : RMCP - Remote Music Control Protocol -- Design and Applications ; Proceedings of 1997 International Computer Music Conference, ICMA, pp.446-449, (1997)

[49] 後藤真孝, 他 : RMCP - 遠隔音楽制御用プロトコルを中心とした音楽情報処理 ; 情報処理学会論文誌 Vol.40, No.3, 情報処理学会, pp.1335-1345, (1999)

[50] 長嶋洋一, 他 : "Improvisession" - ネットワークを利用した即興演奏支援システム ; 情報処理学会研究報告 Vol.97,No.67, 情報処理学会, pp.25-30, (1997)

[51] 中村文隆, 長嶋洋一 : 多数決制を取り入れたリアルタイムネットワークセッション --"Improvisession"から"Democratyrant"へ-- ; 情報処理学会研究報告 Vol.98,No.74, 情報処理学会, pp.87-94, (1998)

[52] 後藤真孝, 根山亮 : 不特定多数による遅延を考慮した遠隔セッションシステム ; 情報処理学会研究報告 Vol.98,No.74, 情報処理学会, pp.95-102, (1997)

[53] 後藤真孝, 根山亮 : Open RemoteGIG - 遅延を考慮した不特定多数による遠隔セッションシステム ; 情報処理学会論文誌 Vol.43,No.2, 情報処理学会, pp.299-309, (2002)

[54] http://nagasm.org/ASL/iwec2002/

[55] http://cnmat.cnmat.berkeley.edu/OSC/

[56] W.Matthew et al. : OpenSound Control - A New Protocol for Communicating with Sound Synthesizers ; Proceedings of 1997 International Computer Music Conference, ICMA, pp.101-104, (1997)

|