宇宙人音楽と人体音楽の作曲事例報告

長嶋 洋一

1. はじめに

Computer Music音響創作活動の新しい事例報告として、Max/MSPをベースとしたアルゴリズム作曲の手法[1]により2002年後半に作曲した、2件の実例を紹介する。第一は、2002年8月に名古屋で公演されたジーン・カルロ・メノッティ(1911-)作曲の、「子供と子供を愛する人々のための」というオペラ "Help, Help, the Globolinks!" の電子音響パートの作曲で、宇宙人Globolinksの声などを従来のテープに代わってリアルタイム音響合成してライブ公演した。第二は、2002年10月から放送されているSony "Net MDウォークマン" のラジオCMのうち「人体の音楽」編として企画された1分間の音楽の作曲で、心臓および腕の筋肉から得られたライブ生体情報([2-10])から、単にパラメータを楽器音にマッピングする従来手法でなく、直接に生体音響音楽を音響生成した。一見すると新しいようなアプローチの中に、温故知新とも言えるノウハウを活用した事例でもある。2. 宇宙人の音楽

2-1. その発端

この企画は、名古屋二期会メンバーを中心にしたオペラ公演団体が、多くのオペラ等を作曲しているカルロ・メノッティ(1911-)の「子供と子供を愛する人々のための」と但し書きされたオペラ "Help, Help, the Globolinks!" の公演を計画し、その指揮を大阪室内歌劇場主宰・音楽監督・指揮者である富岡健氏に委嘱した事が発端である。神戸山手女子短期大学音楽科での交流があった縁で、富岡氏はこの作品の電子音響パートの作曲・演奏を筆者に依頼してきた。

オペラ公演のチラシ表面 裏面 2-2. その課題

この作品 "Help, Help, the Globolinks!" では宇宙人Globolinksが複数出演するが、その声、あるいはGlobolinksが現れる場面やその存在を予感させる場面などで、スコアに合計38箇所の「テープ」という音響効果の指示がある(図は、ボーカルスコアに図形的に描かれた電子音響パートの例)。初演された1968年はもちろん、CD化された1998年の録音においても、楽譜の記載のように、従来はこの電子音響パートは全てあらかじめスタジオで制作された「テープ」を再生する、という手法がとられた。しかし実際の公演においては、Globolinksの声と出演している歌手とが交互に掛け合ったり、さらにGlobolinksに触れられたために次第にGlobolinks化していく校長先生(キャスト)の声など、まさに公演のライブのタイミングで出て欲しい音響が多数あり、テープではタイミングがずれたり外れたりすることでその存在感が大きく失われる欠点があった。事実、録音市販されているCDや過去の公演の記録でも、このような問題はそのまま解決できずにいた。

"Help, Help, the Globolinks!" スコアの第1ページ 2-3. その解決手法

そこで、Computer Musicの手法により、この公演ではライブComputer Musicパートを担当する筆者がオーケストラピットに入り、オーケストラとともに指揮者に合わせてその場でコンピュータによって全ての電子音響パートをライブに生成する、という初めての手法をとることに挑戦した。また、フレーズとして重要になるスクールバスのクラクションの音も用意したが、最終的には音源(スピーカ)の位置がステージ奥でありたい、という理由で別にステージそででシンセサイザを演奏した。その一方で、宇宙人の襲来を告げるラジオアナウンサーの声(実際に元アナウンサーが朗読)についても筆者がMax/MSPで音響処理を行うことになった。

オーケストラピットの設置風景 2-4. 宇宙人の声の創作

筆者に宇宙人の知り合いはおらず、ボーカルスコアに記された図形も音量エンベロープ程度のイメージ的な情報しか与えない、つまりはまったく自由、という中での「宇宙人の声」の創作については、温故知新の姿勢を採用した。はるか昔のアナログシンセ時代、ローランドの名機 "SH-3" でホワイトノイズをS/H(サンプルホールド)に入れて時間的離散化させると、まるで宇宙人が喋っているような雰囲気のサウンドが得られた新鮮な経験を思い出し、これをMax/MSPで再現することにした。

ローランドの名機 "SH-3"以下はMax/MSPのランプ関数生成オブジェクト"phasor~"とサンプルホールド処理オブジェク"Ssh~"を用いた簡単な実験パッチであり、これだけでも左右の"phasor~"の入力データを変化させると往年のサウンドが簡単に蘇る。

"S/H"サウンドの簡単な実験パッチ ただし、YMOの音楽と同じようにこのままでは単調さに気付くまでに数秒しかかからないので、この"phasor~"の入力データをさらに時間的に変調し、その変調パラメータ(スピード、深さ、最大値、最小値など)をランダム要素とともに変化させてやればよい。実際に一匹(一人)分の宇宙人Globolinksの「声」として作品公演に使ったのは以下のようなパッチであり、これをステージに登場する3匹(3人)に合わせて3系列並べて用意して、それぞれのパラメータを身長(声域)と対応させて基本的な変化をつけた。

"Globolinks"サウンド生成パッチ 2-5. 宇宙人化する人間の声

ストーリーの中では、宇宙人Globolinksに触れた人間は次第にGlobolinksになってしまう事になっており、Globolinksの唯一の弱点である「音楽を聞かせる」という事を重視しない校長先生が、あわれにもGlobolinksに触れられてしまう、という展開である。そこでは、他の先生との掛け合いで、人間の声が次第にGlobolinksに変化していくサウンドが要求された。

離散的S/Hによる宇宙人サウンドと人間の声との間でメタモルフォーゼさせる、といえばもう定番のテクニックはコンボリューション(畳み込み)であり、Max/MSPのサンプルにはちょうど便利な "convolvefft~"がある。

畳み込みパッチ"convolvefft~" この畳み込みの一方に前述のGlobolinksの声をそのまま使用するだけでなく、もう一方の「人間の音声」にも工夫した。なんらかの会話音声を使った場合、その意味的な情報が公演においては却って邪魔になる。そこで、劇中に使用した元アナウンサーの朗読音声を逆回しして(日本語の逆回しは韓国語などの雰囲気に聞こえることはよく知られている)、これを畳み込みのもう一方の入力とした。以下は、この実験のために制作したパッチ"Globolizer"で、ライブのマイク入力に対して前述のGlobolinksの声を畳み込む、という動作をするものである。

音声加工ソフト"Globolizer"のパッチ

2-6. その他の音響創作

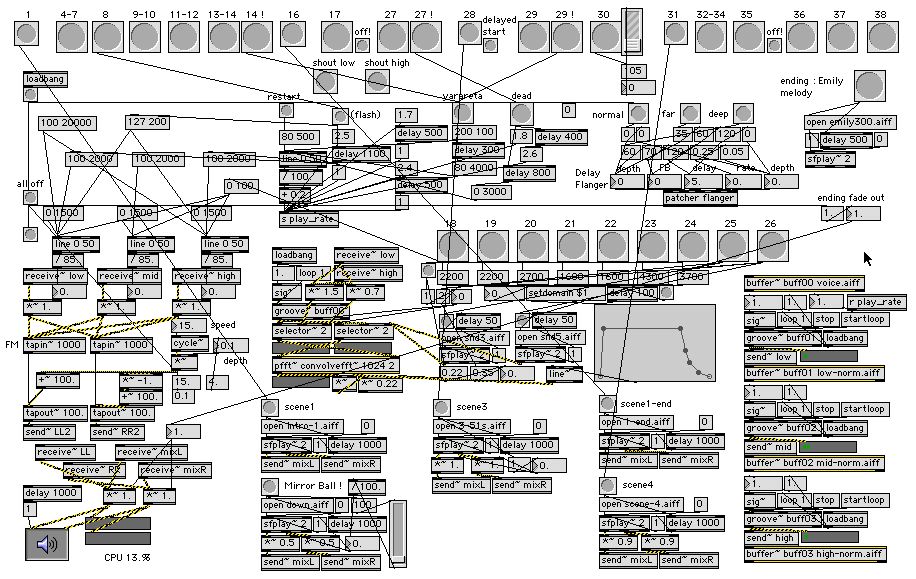

この作品のその他の電子音響パートとしては、シーンごとに「深遠な宇宙」「金属の森」などの雰囲気を醸し出す「宇宙的サウンド」の要請があり、これはKymaシステムを用いてあらかじめスタジオ制作したサウンドファイルをMax/MSPで必要に応じて多重再生することとした。また、ラジオで宇宙人の襲来を告げるアナウンサー音声についても、ラジオのフェージングノイズ、チューニングのビート、ホワイトノイズにかき消されて途絶える、といったアナログ的な効果をMax/MSPで加えたCDとして作成した。以下は公演の本番(昼の部のバージョンに改良を加え、夜の部の公演)で使用したパッチである。

本番でライブ使用したパッチ以下は、上のMax/MSPメインパッチ中で使用したサブパッチ"flanger"であり、MSPサンプルを改造しただけのシンプルな多機能ディレイ音響処理ブロックである。オペラの公演中は、場面ごとのGlobolinksのステージ上の位置や消え去る距離感に対応した残響量を刻々と変化させたり、ランダム要素とともに時間的変調をかけたフランジャー効果などを生成した。

サブパッチ"flanger"

2-7. 公演の模様

以下は、名古屋・アートピアホール(昼夜の2回公演のリハーサル)の模様である。客席前方ステージ前のオーケストラピットの隅にコンピュータデスクを置いて筆者がライブでコンピュータをトラックボール操作した。客席から指揮者以外の演奏者の頭が見えては格好悪いために、筆者の位置からはステージ上での歌手の動きが見えないために、計画していたタイミングから最大で0.5秒程度のずれが起きたのが反省点であるが、テープ操作に比べて非常に良好なレスポンスで演技と絡むことができた。

オーケストラピットとステージの位置関係 3. 人体の音楽

3-1. その発端

この企画は、Sonyのラジオ番組向けCMの制作を委託されたプロダクションからの突然の打診メイルが来てスタートした。筆者はこの企業とは面識もないが、プロデューサが「生体と音楽」をネットでサーチしていたところ、至る所で筆者のサイトに行き着くので遂に連絡してきた、という話であった。筆者はサイトのリンク等を宣伝していないので詳細は不明である。3-2. 企画内容と依頼内容

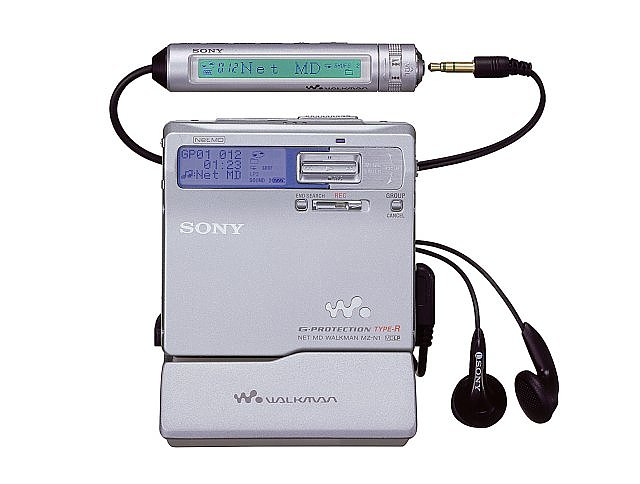

このSonyのラジオ番組向けCM音楽は、"Net MDウォークマン"という製品のためのものであり、「インターネットの世界には僕達の知らない音楽がたくさんある」という、珍しい音楽を紹介するコンセプトであった。そして「インディーズ編」「ホーミー編」と並んで、目玉として「人体の音楽編」という企画が生まれ、そのサウンドの制作を依頼された。

Sony "Net MDウォークマン"以下は、このプロデューサのメイルによる当初のシナリオ案であり、筆者の提供する1分間の「人体音楽」のサウンドが、ナレーションやSEによるポストプロダクション加工により最終的なCMとなるアウトラインが示された。

打合せの結果、人体の情報の中で「心臓の鼓動」「筋電位信号」の2種類をサウンドとして利用した音楽を作曲する事、難解な現代音楽的でなくポップなフィーリング(ビートやコード/スケール感)を盛り込む事、等を決定した。ソニーNet MDウォークマン ラジオCM60秒 「人体の音楽」篇 子供:僕たちは、いったいどれだけの音楽を 知っているというのだろう。 男: 心臓の動きを、音に置き換える。 ME1:心臓の音 筋肉の動きを、音に置き換える。 2:筋肉の音 人体の電気信号を抽出して、 3:人体の音 音の信号にしてしまう実験。 …これも、音楽。 ♪〜次にこれらをMIXして 音楽的なものにしていきます 男: インターネットには、 僕らが体験したことのない 音楽があふれている。 いま出会った音楽が、もうMDになった。 ソニー Net MDウォークマン。 SL:SONY〜SONY〜3-3. 心臓の鼓動音のサンプリング

名曲"Dark Side of the Moon"の冒頭や末尾の実例を待つまでもなく、人間の心臓の鼓動というのは音楽のテンポAndanteなどの基準としてあまりに一般的であり、MIDIでGM音源の低音を等間隔に叩くだけでも雰囲気が再現できる。

名曲"Dark Side of the Moon"ここでは「生の心拍音」にこだわり、まず防音室で自分の心拍音を録音した。使用したマイクロホンは以下のcountryman ISOMAX-2Hで、これをガムテープで左胸に貼付けて44.1KHzサンプリングでDATに録音した。数種類のテイクからSGI soundeditorで衣擦れなどのノイズの無い部分を抽出しAIFFファイルとした。

心拍音の録音に使用したマイクロホン

余談であるが、医学的な理由があり筆者は心拍を意志力で若干ルバートできるが、そのようにテンポとともに音量も微妙に揺らいだりばらついた自然な心臓の鼓動サウンドは有効であった。特に心拍音響のエンベロープ形状やピークレベルの大きなばらつきが、聴感上の「自然さ」に大きく影響した点を指摘しておきたい。

3-4. 筋電情報のサンプリング

筆者は過去に3世代にわたるオリジナル筋電センサを開発し、具体的な作曲・公演に活用してきた([11-13])が、今回は16チャンネル同時検出の必要はないので、初代のMiniBioMuse-Iを使用して、両手首の間に発生する腕の筋電情報をライブサンプリングした。記録は筋電ノイズの生サウンド信号とMIDI変換されたデータの両方が得られたが、実際に作曲の中で利用したのはSMF形式で保存した後者の方である。

筋電情報のサンプリング風景

3-5. 「人体音楽」の作曲

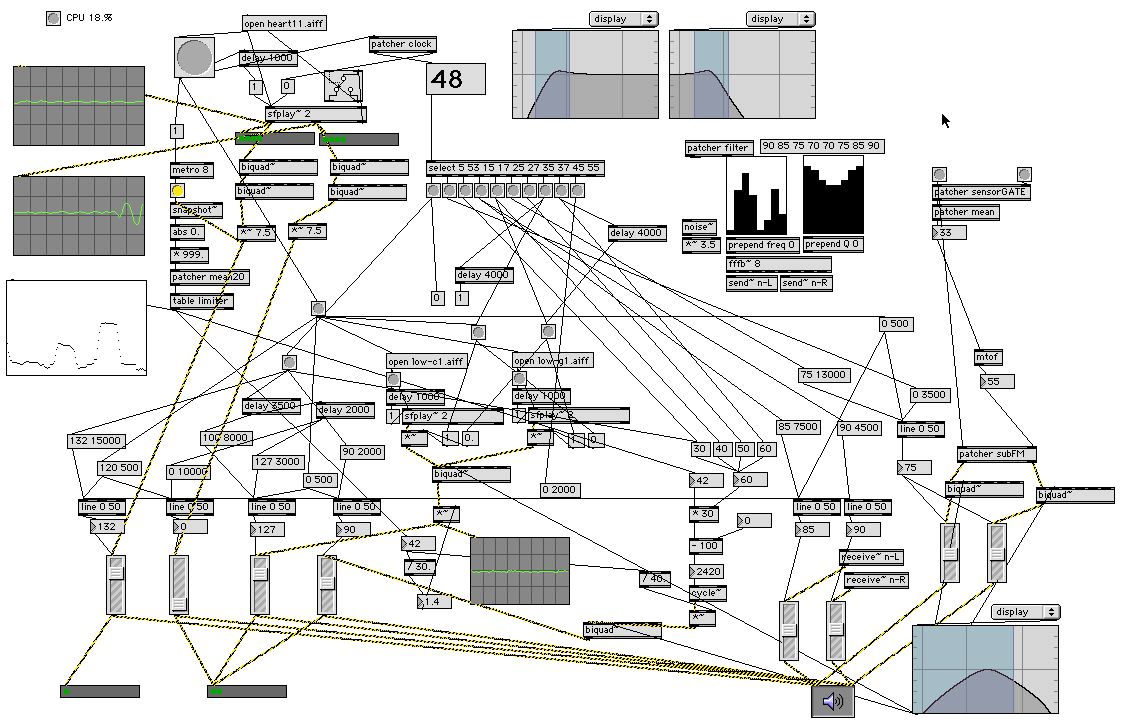

音楽情報科学研究会の予稿では紙面の制限であまり記述できなかったので、ここで具体的に生体情報をアルゴリズミックに用いて作曲した手法の詳細として、実際に実験と作曲に使用したMax/MSPパッチの実例とともに、その作曲の過程を紹介する。最終提出CDの演奏時間を確定させるため、実際のレコーディングにおいては以下のように、パッチとしてシーケンサ的な自動パラメータ推移機構を構築し、一部を即興的に操作した。以降の解説は、このそれぞれの要素的な実験と試行錯誤の記録である。

最終的な作曲パッチの一例

3-5-1. 心拍検出

下図のパッチ"heart2"は、この作曲作業ディレクトリに置かれたMax/MSPパッチでもっともタイムスタンプの古いものである。

心拍検出パッチ"heart2"ここでは下図のような心拍録音サウンドファイルを"wavebank"と名付けたバッファに読み込んでエンドレス再生し、まずは波形表示とともにそのままサウンド出力している。

心拍録音サウンドファイルまた、このサウンド再生データをsnapshot~オブジェクトで20msecごとにキャプチャー(サンプリング)してデータ化し、以下の5ステージ移動平均サブパッチによって積分して、瞬間的なノイズをローパスフィルタとしてカットするとともに時間的に滑らかな変化データを得ている。

移動平均サブパッチそしてこの実験パッチでは、この積分された変動データをスレショルド値と比較して、これを越えるとその値をGM音源のノートイベントとしてピッチを与えて、心拍と同期した楽器音をとりあえず鳴らしてみている。

3-5-2. 筋電検出

下図のパッチ"muscle1"では、筋電センサであらかじめ計測検出してSMF形式に保存してあった筋電情報ファイルを読み込んでエンドレス再生し、ホワイトノイズを入力したbiquadフィルタのカットオフ周波数の変化として与えることで、擬似的な筋電サウンドを生成している。

筋電検出パッチ"muscle1"

3-5-3. 心拍サウンドの実験(1)

下図のパッチ"sony01"では、前述の心拍情報を、オペラで活用した「実時間畳み込み」によって一般のサウンドファイル(ここでは通常の音楽演奏サウンド)に作用させる、という実験を行った。

実験パッチ"sony01"

3-5-4. 心拍サウンドの実験(2)

下図のパッチ"sony02"では、前述の心拍情報を、「マルチバンドパスフィルタにホワイトノイズを与えたところのカットオフ制御に利用」、という実験を行った。

実験パッチ"sony02"

3-5-5. 心拍サウンドの実験(3)

下図のパッチ"sony05"では、前述の心拍情報を移動平均により滑らかにして、その音量エンベロープに従った周波数のサイン波形オシレータを音源とするとともに、デチューンによるアナログシンセ的なサウンドも同時に生成する実験を行っている。

実験パッチ"sony05"

3-5-6. 試作作曲(1)

下図のパッチ"sony07"は、1分間という時間の経過に応じた音量バランス変化(フェード)をプログラミングして、実際に1分間のサウンド作品を試作した例である。ここではまず、冒頭で生の心拍サウンドが出て、次いで心拍に同期したデチューンシンセの完全5度関係の低音が加わる。そして心拍エンベロープの振幅に基づくピッチのサインオシレータのサウンドが加わり、さらに筋電情報に対応したホワイトノイズが出現する。最後に、筋電情報に対応して一定のスケールに基づくGM音源の楽器音が加わってからフェイドアウトしている。

試作パッチ"sony07"

3-5-7. 試作作曲(2)

下図のパッチ"sony08"は、心拍に同期したエンベロープ変調を受ける低音部分パートとして、合成シンセ音でなく、水のサウンドと風のサウンド、という自然音を使用してみた例である。

試作パッチ"sony08"

3-5-8. 試作作曲(3)

下図のパッチ"sony09"は、心拍に同期したエンベロープ変調を受ける低音部分パートとして、別のGM音源でストリングス系低音によるロングトーンを用意して、完全5度インターバルの通奏低音としてみた例である。

試作パッチ"sony09"

3-5-9. 試作作曲(4)

下図のパッチ"sony10"は、パッチ"sony09"のGM楽器音による簡易メロディーのスケールを変更してみた例である。

試作パッチ"sony10"

3-5-10. 試作作曲(5)

下図のパッチ"sony11"は、筋電情報に対応したサウンドとして、楽器音でなく、リアルタイムFM合成のパラメータを変化させて過激な音色を求めてみた例である。

試作パッチ"sony11"

3-5-11. 試作作曲(6)

以上の5種類の試作サウンドファイルを制作したところで、作曲を依頼されたスタジオにMP3データとして提供して検討してもらい、いくつかのリクエストを受けて、サウンド素材としてさらに2種類の改訂パッチを制作した。そしてここで得られたサウンドを最終作品として提出して、あとはこのスタジオのポストプロダクションによってCMが制作された。著作権の関係で、ここでは完成されたCMのサウンドファイルは置いていないので、聴きたい人はぜひSony提供の放送を聴取されたい。 ★ ★ ★4. おわりに

Computer Music音響創作活動の事例報告として2件を紹介した[14]。リアルタイム信号処理環境としてMax/MSPを活用することにより、アルゴリズミックにサウンドレベル(従来のノートレベルでなく)の作曲も容易に実現できることの確認となった。今後も機会があれば、さらに新しい/面白いサウンドを探究していきたい。参考文献

[1] 長嶋洋一 : アルゴリズム作曲 ; コンピュータと音楽の世界, 共立出版, 1998

[2] 長嶋洋一 : コンピュータサウンドの世界, CQ出版, 1998

[3] http://nagasm.org/1106/news/araessassa/index.html

[4] http://nagasm.org/ASL/dspss2002/index.html

[5] http://nagasm.org/ASL/SIGMUS0108/index.html

[6] http://nagasm.org/ASL/suac2002/index.html

[7] http://nagasm.org/ASL/body/index.html

[8] http://nagasm.org/ASL/sensor03/index.html

[9] http://nagasm.org/ASL/sound02/index.html

[10] http://nagasm.org/ASL/SICE2/index.html

[11] http://nagasm.org/ASL/mbm-1/index.html

[12] http://nagasm.org/ASL/mbm-2/index.html

[13] http://nagasm.org/ASL/mbm-3/index.html

[14] http://nagasm.org/ASL/SIGMUS0302/index.html

[15] http://nagasm.org/ASL/SIGMUS0202/index.html

PDF版